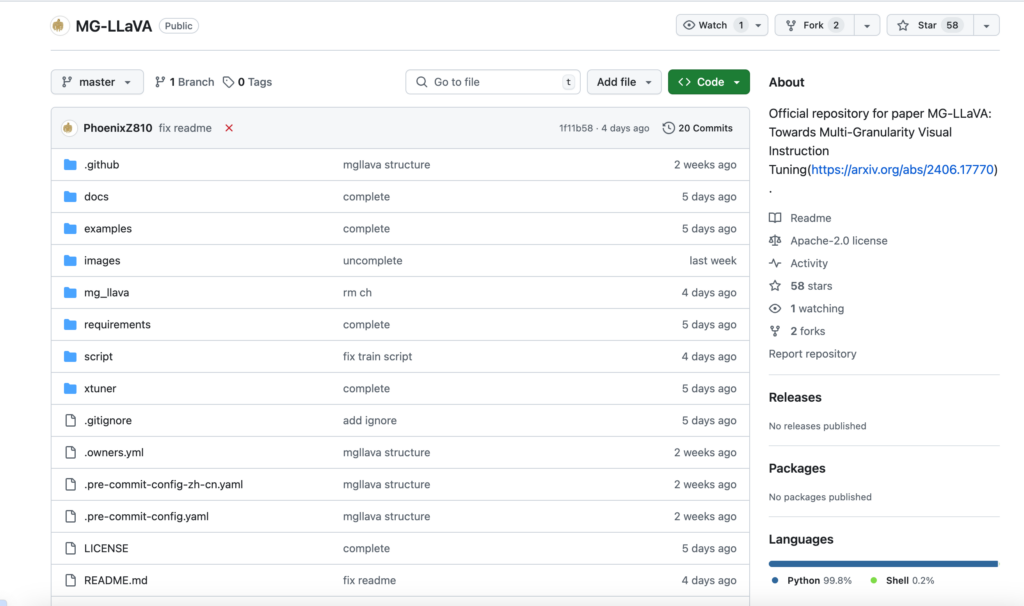

連結:https://github.com/phoenixz810/mg-llava

MG-LLaVA是一個增強模型視覺處理能力的機器學習語言模型(MLLM),透過整合多粒度視覺流程,包括低解析度、高解析度和以對象為中心的特徵。提出了一個額外的高解析度視覺編碼器來捕捉細節,並透過Conv-Gate融合網路與基礎視覺特徵融合。此外,透過離線偵測器辨識的邊界框整合對象級特徵,以進一步細化模型的對象辨識能力。MG-LLaVA僅在公開可用的多模態資料上透過指令調優進行訓練,展現出卓越的感知技能。

需求人群:

“MG-LLaVA主要面向機器學習研究者和開發者,特別是那些專注於視覺語言模型和多模態學習領網網域的專業人士。它適合需要處理大量視覺和文本資料,並且希望提升模型在影象辨識和文本理解方面效能的使用者。”

使用場景示例:

研究人員使用MG-LLaVA進行影象和文本的聯合學習,以提高模型在多模態任務上的表現。

開發者利用MG-LLaVA對社交媒體上的影象和留言進行分析,以提取使用者情感和偏好。

企業使用MG-LLaVA最佳化其產品的視覺搜尋功能,以提供更準確的影象匹配和推薦。

產品特色:

增強視覺處理能力:透過多粒度視覺流程提升模型對視覺資訊的處理。

細節捕捉:使用高解析度視覺編碼器捕捉影象中的細微特徵。

特徵融合:透過Conv-Gate融合網路整合不同解析度的視覺特徵。

對象辨識能力提升:利用邊界框辨識的物體級特徵增強模型的辨識能力。

指令調優訓練:僅使用公開可用的多模態資料進行訓練,提高模型的泛化能力。

兩階段訓練過程:包括預訓練、微調和評估,以最佳化模型效能。

支援DeepSpeed最佳化:使用DeepSpeed技術加速訓練過程。

使用教學:

1. 安裝Python-3.10虛擬環境,並啟用。

2. 從原始碼安裝XTuner。

3. 根據dataset_prepare.md準備資料。

4. 下載所需的LLM和CLIP檢查點檔案。

5. 根據個人設定修改設定檔中的變數。

6. 使用提供的腳本開始預訓練、微調和評估過程。

7. 根據需要,將訓練好的模型轉換為Hugging Face模型格式。