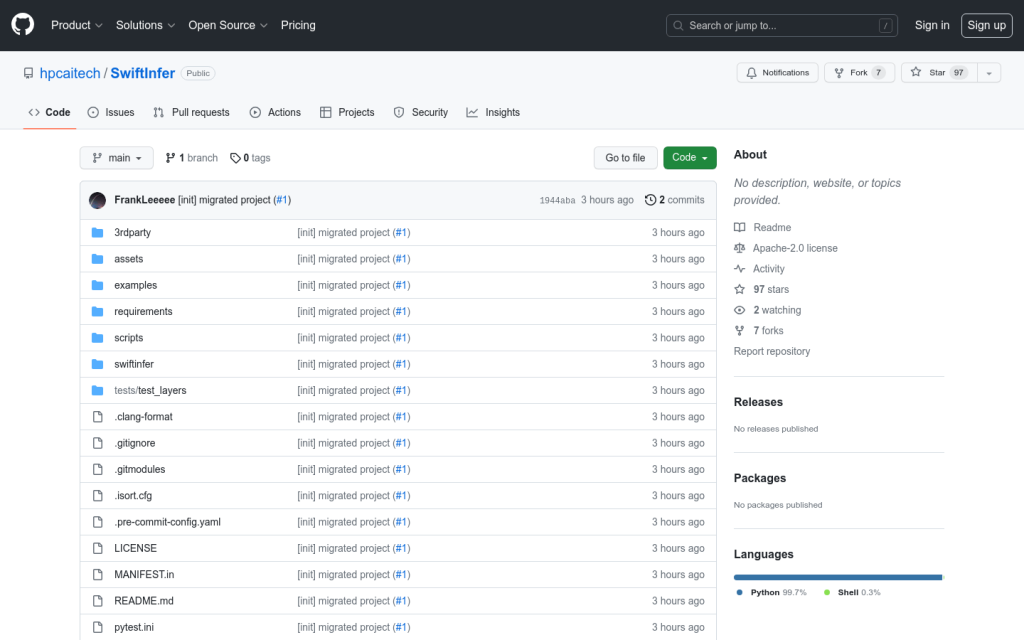

Link:swiftinfer

SwiftInfer是一個基於Nvidia TensorRT框架的大規模語言模型(LLM)推理加速庫,透過GPU加速,極大提升LLM在生產環境中的推理效能。該專案針對流式語言模型提出的Attention Sink機制進行了實現,支援無限長度的文字生成。程式碼簡潔,執行方便,支援主流的大規模語言模型。

需求人群:

"可應用於聊天機器人、長文字生成等需要LLM推理的場景"

使用場景示例:

基於Llama模型的問答聊天機器人

自動新聞摘要生成系統

根據產品描述自動生成營銷文案

產品特色:

支援流式語言模型推理,可處理超長文字

GPU加速,推理速度較Pytorch原實現提升3-5倍

支援TensorRT部署,方便生產環境整合

提供示例程式碼,能快速上手實際應用