連結:https://mhamilton.net/denseav

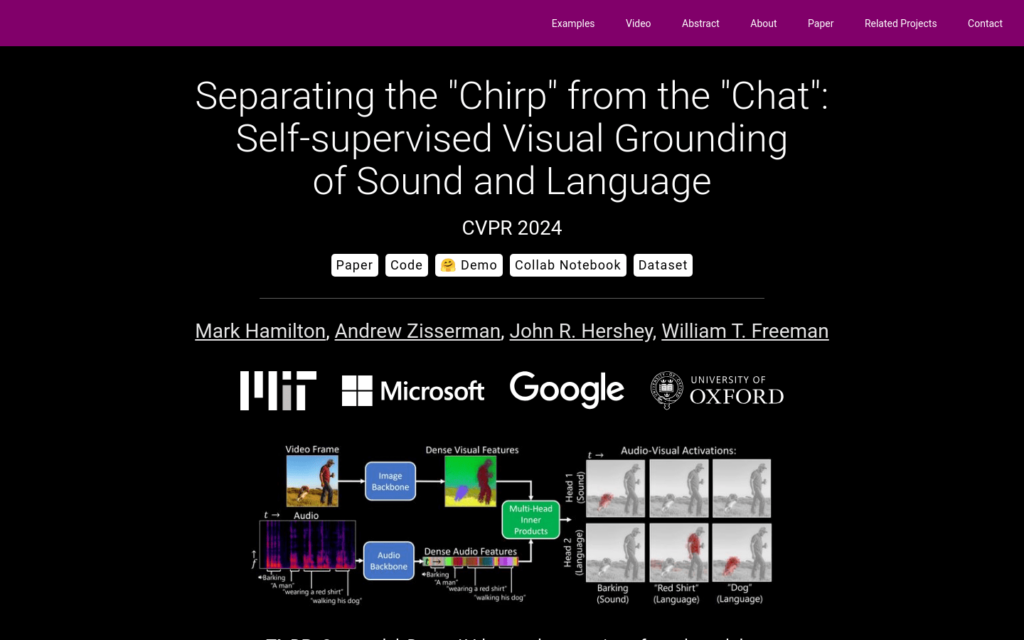

DenseAV是一種新穎的雙編碼器定位架構,透過觀看影片學習高解析度、語義有意義的視聽對齊特徵。它能夠無需明確定位監督即可發現單詞的「意義」和聲音的「位置」,並且自動發現並區分這兩種關聯型別。DenseAV的定位能力來自於一種新的多頭特徵聚合運運算元,它直接比較密集的影象和音訊表示進行對比學習。此外,DenseAV在語義分割任務上顯著超越了先前的藝術水平,並且在使用引數少於一半的情況下,在跨模態檢索上超越了ImageBind。

需求人群:

- DenseAV適用於需要從影片內容中自動提取語義資訊的研究者和開發者,特別是在沒有明確標註資料的情況下進行視聽內容分析的領網網域。

使用場景示例:

- 在自然語言處理領網網域,用於理解影片中的對話內容和場景。

- 在影片內容分析中,用於辨識和定位影片中的關鍵聲音和物體。

- 在多媒體檢索系統中,用於改善基於聲音和語言的檢索效果。

產品特色:

- 無需監督即可從影片中發現單詞意義和聲音位置。

- 使用多頭特徵聚合運運算元進行對比學習。

- 在沒有標籤的情況下透過自監督學習模式。

- 在語義分割任務上超越先前的藝術水平。

- 在跨模態檢索上使用更少的引數超越ImageBind。

- 為提高視聽表示評估貢獻了兩個新的資料集。

使用教學:

1. 訪問DenseAV的網頁連結,瞭解模型的基本資訊。

2. 閱讀DenseAV的論文,理解其背後的技術和原理。

3. 根據DenseAV提供的程式碼和資料集,進行模型訓練和測試。

4. 利用DenseAV的定位能力,對影片內容進行語義分割。

5. 應用DenseAV在跨模態檢索任務中,提高檢索的準確性。

6. 根據反饋和結果,調整模型引數以最佳化效能。