連結:https://huggingface.co/microsoft/Florence-2-base-ft

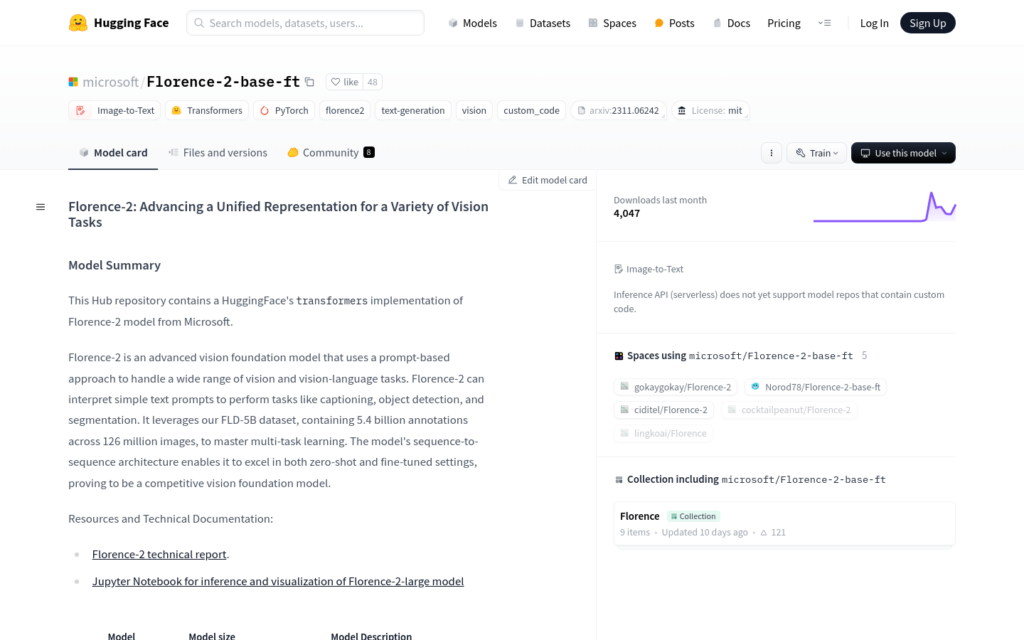

Florence-2是由微軟開發的高階視覺基礎模型,採用基於提示的方法處理廣泛的視覺和視覺-語言任務。該模型能夠解釋簡單的文本提示,執行諸如影象描述、目標偵測和分割等任務。它利用FLD-5B資料集,包含54億個註釋,覆蓋1.26億張影象,精通多工學習。其序列到序列的架構使其在零樣本和微調設定中均表現出色,證明是一個有競爭力的視覺基礎模型。

需求人群:

“目標受眾為需要進行影象處理和視覺-語言任務的研究人員和開發者。無論是學術研究還是商業應用,Florence-2都能提供強大的影象理解和生成能力,幫助使用者在影象描述、目標偵測等領網網域取得突破。”

使用場景示例:

研究人員使用Florence-2模型進行影象描述生成任務,以自動生成影象的描述性文本。

開發者利用Florence-2進行目標偵測,以實作影象中物體的自動辨識和分類。

企業使用Florence-2進行產品影象的自動標註和描述,以最佳化搜尋引擎最佳化(SEO)和提升使用者體驗。

產品特色:

影象到文本轉換:能夠將影象內容轉換為文本描述。

多工學習:模型支援多種視覺任務,如影象描述、目標偵測、區網網域分割等。

零樣本和微調效能:在沒有訓練資料的情況下也能表現出色,且微調後效能進一步提升。

基於提示的方法:透過簡單的文本提示即可執行特定任務。

序列到序列架構:模型採用序列到序列架構,能夠生成連貫的文本輸出。

自訂程式碼支援:允許使用者根據自己的需求定製程式碼。

技術文檔和示例:提供技術報告和Jupyter Notebook,方便使用者進行推理和視覺化。

使用教學:

步驟1:匯入必要的庫,如requests、PIL、transformers等。

步驟2:使用AutoModelForCausalLM和AutoProcessor從預訓練模型中載入Florence-2模型。

步驟3:定義要執行的任務提示,如影象描述、目標偵測等。

步驟4:下載或載入需要處理的影象。

步驟5:使用處理器將文本和影象轉換為模型可接受的輸入格式。

步驟6:呼叫模型的generate方法生成輸出。

步驟7:使用處理器解碼生成的文本,並根據任務進行後處理。

步驟8:列印或輸出最終結果,如影象描述、偵測框等。