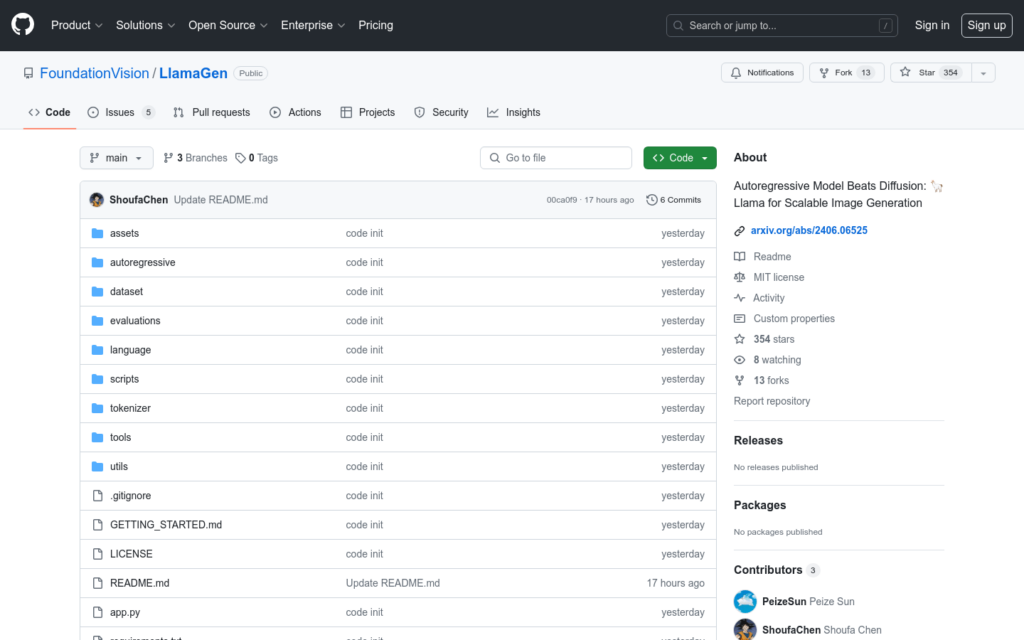

連結:https://github.com/FoundationVision/LlamaGen

LlamaGen是一個新的影象生成模型家族,它將大型語言模型的原始下一個token預測範式應用於視覺生成領網網域。該模型透過適當的擴充,無需對視覺訊號的歸納偏差即可實作最先進的影象生成效能。LlamaGen重新審視了影象分詞器的設計空間、影象生成模型的可擴充性屬性以及它們的訓練資料質量。

需求人群:

- LlamaGen的目標受眾是影象生成領網網域的研究人員和開發者,特別是那些對利用自迴歸模型進行高質量影象合成感興趣的人。它適合需要生成高質量影象的AI藝術家、遊戲開發者、電影製作者以及任何需要影象生成技術的行業。

使用場景示例:

- 使用LlamaGen生成特定風格的藝術作品。

- 在遊戲開發中,使用LlamaGen快速生成遊戲內環境和角色的影象。

- 電影製作中,利用LlamaGen建立逼真的背景和場景。

產品特色:

- 提供兩種影象分詞器,下采樣比率分別為16和8。

- 釋出七個類條件生成模型,引數從100M到3B不等。

- 提供兩個文本條件生成模型,引數為700M。

- 支援線上演示,執行預訓練模型。

- 支援LLM服務框架,可實作300% – 400%的速度提升。

- 類條件影象生成在ImageNet上的應用。

- 文本條件影象生成,使用LAION COCO資料集和內部資料。

使用教學:

訪問LlamaGen的GitHub頁面並克隆或下載程式碼。

閱讀並遵循GETTING_STARTED.md檔案中的安裝指南。

下載預訓練模型並將其放置在指定的資料夾中。

執行提供的腳本以生成影象,檢視生成結果。

根據需要調整引數和設定以最佳化生成的影象。