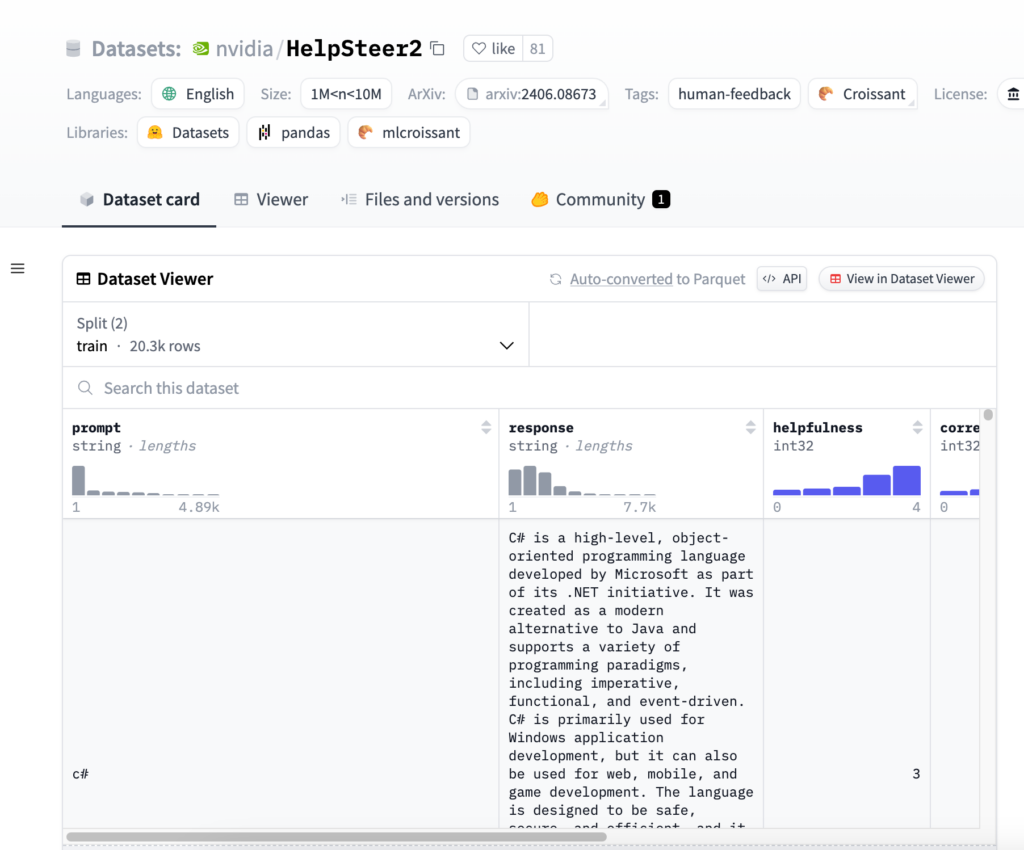

連結:https://huggingface.co/datasets/nvidia/HelpSteer2

HelpSteer2是由NVIDIA釋出的一個開源資料集,旨在支援訓練能夠對齊模型以使其更加有幫助、事實正確和連貫,同時在響應的複雜性和冗餘度方面具有可調節性。該資料集與Scale AI合作建立,當與Llama 3 70B基礎模型一起使用時,在RewardBench上達到了88.8%的表現,是截至2024年6月12日最佳的獎勵模型之一。

需求人群:

- HelpSteer2資料集主要面向需要訓練和最佳化對話系統、獎勵模型和語言模型的開發者和研究人員。它特別適合那些希望提高模型在特定任務上表現的專業人士,例如客戶服務自動化、虛擬助手或任何需要自然語言理解和生成的場景。

使用場景示例:

- 用於訓練SteerLM迴歸獎勵模型,提高對話系統在特定任務上的表現。

- 作為研究專案的一部分,分析和比較不同模型在處理多輪對話時的響應質量。

- 在教育領網網域,幫助學生理解如何透過機器學習技術來改進語言模型的響應。

產品特色:

- 包含21,362個樣本,每個樣本包括一個提示、一個響應以及五個人類標註的屬性評分。

- 屬性評分包括幫助性、正確性、連貫性、複雜性和冗餘度。

- 支援多輪對話的樣本,可以用於基於偏好對的DPO或Preference RM訓練。

- 響應由10種不同的內部大型語言模型生成,提供多樣化但合理的響應。

- 使用Scale AI進行標註,確保了資料集的質量和一致性。

- 資料集遵循CC-BY-4.0許可,可以自由使用和分發。

使用教學:

步驟1:訪問Hugging Face官網並搜尋HelpSteer2資料集。

步驟2:下載資料集,並使用適當的工具或庫載入資料集。

步驟3:根據專案需求,選擇資料集中的特定樣本或屬性進行分析。

步驟4:使用資料集訓練或最佳化你的語言模型,監控模型在各個屬性上的表現。

步驟5:調整模型引數,根據需要改進模型的訓練過程。

步驟6:評估模型效能,確保其在幫助性、正確性和其他關鍵屬性上達到預期標準。

步驟7:將訓練好的模型部署到實際應用中,如聊天機器人或虛擬助手。