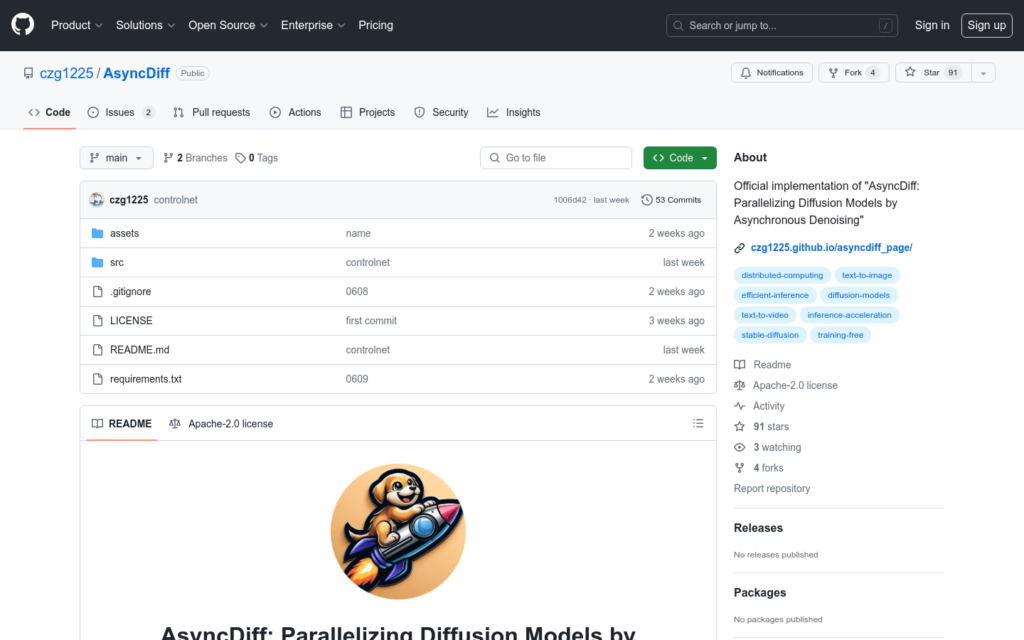

連結:https://github.com/czg1225/AsyncDiff

AsyncDiff 是一種用於並行化擴散模型的非同步去噪加速方案,它透過將噪音預測模型分割成多個元件並分配到不同的設備上,實作了模型的並行處理。這種方法顯著減少了推理延遲,同時對生成質量的影響很小。AsyncDiff 支援多種擴散模型,包括 Stable Diffusion 2.1、Stable Diffusion 1.5、Stable Diffusion x4 Upscaler、Stable Diffusion XL 1.0、ControlNet、Stable Video Diffusion 和 AnimateDiff。

需求人群:

- AsyncDiff 適合需要進行高效影象生成和影片生成的研究人員和開發者。特別適用於尋求降低深度學習模型推理時間,同時保持生成內容質量的應用場景。

使用場景示例:

- 使用 AsyncDiff 加速 Stable Diffusion XL 的影象生成過程

- 透過 AsyncDiff 並行化處理 ControlNet 模型以提升影片生成效率

- 利用 AsyncDiff 對 Stable Diffusion x4 Upscaler 進行加速,以快速生成高解析度影象

產品特色:

- 支援多種擴散模型並行化加速,如Stable Diffusion 2.1、Stable Diffusion 1.5、Stable Diffusion x4 Upscaler等。

- 透過分割噪音預測模型實作設備間的平行計算,有效降低推理延遲。

- 減少推理延遲,保持生成質量,適用於高效的影象和影片生成。

- 提供詳細的腳本以加速特定模型的推理過程,方便使用者進行定製化最佳化。

- 支援 ControlNet、Stable Diffusion XL 等多種模型,靈活適應不同的應用場景。

- 提供靈活的配置選項以適應不同的平行計算需求,使得非同步並行推理更加方便。

- 易於整合,僅需新增少量程式碼即可啟用非同步並行推理,降低開發成本。

使用教學:

安裝必要的環境和依賴,包括 NVIDIA GPU、CUDA 和 CuDNN,確保系統支援平行計算。

建立 Python 環境並啟用,然後安裝 AsyncDiff 的依賴包,以便進行非同步並行推理。

在現有的擴散模型程式碼中引入 AsyncDiff,並進行必要的配置,比如分割數量和去噪步長。

根據需求選擇並配置模型分割的數量、去噪步長和預熱階段,以滿足不同的平行計算需求。

執行提供的示例腳本或自訂腳本來執行並行推理,評估加速效果。

根據輸出結果評估 AsyncDiff 加速效果,並進行必要的調整,以達到最佳效能。