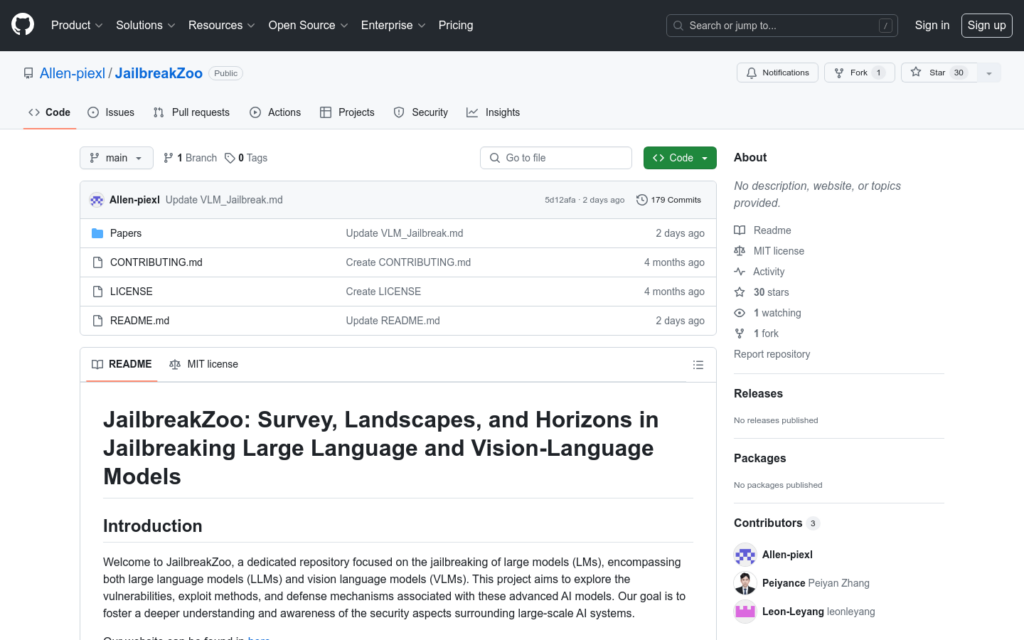

連結:https://github.com/Allen-piexl/JailbreakZoo

JailbreakZoo是一個專注於破解大型模型(包括大型語言模型和視覺語言模型)的資源庫。該專案旨在探索這些高階AI模型的漏洞、利用方法和防禦機制,目的是促進對大規模AI系統安全方面的更深入理解和認識。

需求人群:

- JailbreakZoo的目標受眾是AI安全研究人員、開發者和對大型AI模型安全性感興趣的學者。它為這些使用者提供了一個深入瞭解和研究大型AI模型潛在安全問題的平臺。

使用場景示例:

- 研究人員使用JailbreakZoo來分析最新的大型語言模型的漏洞

- 開發者利用該資源庫中的資訊來增強自己產品的安全性

- 學術界透過JailbreakZoo來教授學生關於AI模型安全的知識

產品特色:

- 系統地組織了根據釋出時間線的大型語言模型破解技術

- 提供了大型語言模型的防禦策略和方法

- 介紹了視覺語言模型特有的漏洞和破解方法

- 包含了視覺語言模型的防禦機制,包括最新進展和策略

- 鼓勵社群貢獻,包括新增新研究、改進文檔或分享破解和防禦策略

使用教學:

訪問JailbreakZoo的GitHub頁面

閱讀介紹部分以瞭解專案目標和背景

瀏覽不同時間線釋出的破解技術和防禦策略

根據需要,檢視特定模型的破解案例或防禦方法

如果願意,可以遵循貢獻指南來提交自己的研究成果或改進意見

在研究或出版物中引用JailbreakZoo時,遵循其引用指南