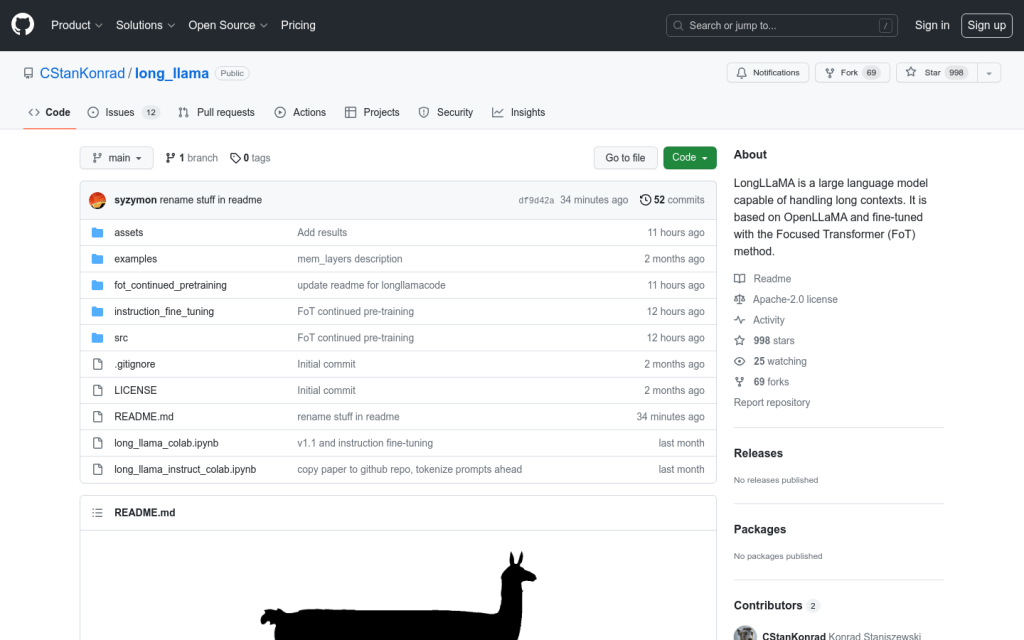

Link:longllama

LongLLaMA 是一個大型語言模型,能夠處理長篇文字。它基於 OpenLLaMA,並使用 Focused Transformer (FoT) 方法進行了微調。它能夠處理長達 256k 標記甚至更多的文字。我們提供了一個較小的 3B 基礎模型(未經過指令調整),並在 Hugging Face 上提供了支援更長上下文的推斷程式碼。我們的模型權重可以作為現有實現中 LLaMA 的替代品(適用於最多 2048 個標記的短上下文)。此外,我們還提供了評估結果和與原始 OpenLLaMA 模型的比較。

需求人群:

"適用於各種自然語言處理任務,如文字生成、文字分類、問答系統等"

產品特色:

處理長篇文字

支援 256k 標記或更長的文字

用於自然語言處理任務