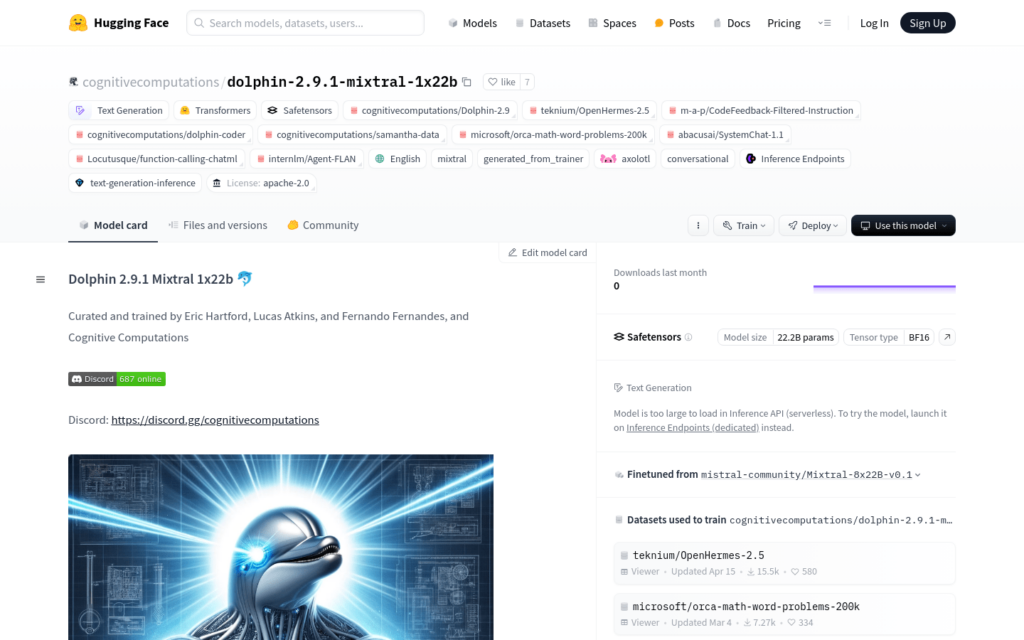

連結:https://huggingface.co/cognitivecomputations/dolphin-2.9.1-mixtral-1x22b

Dolphin 2.9.1 Mixtral 1x22b是由Cognitive Computations團隊精心訓練和策劃的AI模型,基於Dolphin-2.9-Mixtral-8x22b版本,擁有Apache-2.0許可。該模型具備64k上下文容量,透過16k序列長度的全權重微調,經過27小時在8個H100 GPU上的訓練完成。Dolphin 2.9.1具有多樣的指令、對話和編碼技能,還具備初步的代理能力和支援函式呼叫。該模型未進行審查,資料集已過濾去除對齊和偏見,使其更加合規。建議在作為服務公開之前,實施自己的對齊層。

需求人群:

Dolphin 2.9.1 Mixtral 1x22b適合需要高階自然語言處理能力的使用者,如軟體開發者、資料科學家和AI研究者。它能夠處理複雜的指令、對話和程式設計任務,是進行AI驅動的軟體開發和研究的理想選擇。

使用場景示例:

用於開發智慧聊天機器人,提供流暢的對話體驗

輔助程式設計,自動生成程式碼片段,提高開發效率

在教育領網網域,作為教學輔助工具,幫助學生理解複雜概念

產品特色:

支援文本生成,包括指令、對話和編碼技能

具備初步的代理能力和函式呼叫支援

全權重微調,目標所有層

使用SLERP和自訂腳本提取單一專家

資料集過濾去除對齊和偏見,提高合規性

模型透過Apache-2.0許可,支援商業用途