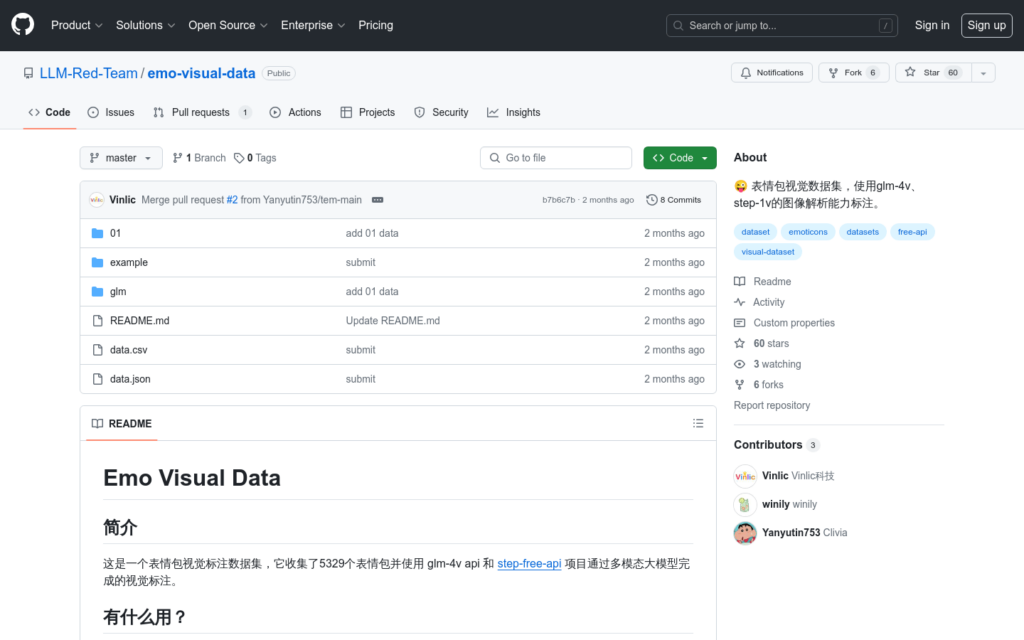

連結:https://github.com/LLM-Red-Team/emo-visual-data

emo-visual-data 是一個公開的表情包視覺標註資料集,它透過使用 glm-4v 和 step-free-api 專案完成的視覺標註,收集了5329個表情包。這個資料集可以用於訓練和測試多模態大模型,對於理解影象內容和文本描述之間的關係具有重要意義。

需求人群:

- 該資料集適合自然語言處理和電腦視覺領網網域的研究人員和開發者,尤其是那些專注於多模態學習和影象標註的專業人士。它可以幫助他們訓練更智慧的模型,提高對影象內容的理解能力。

使用場景示例:

- 研究人員使用該資料集訓練深度學習模型,以提高對社交媒體中表情包的理解。

- 開發者利用資料集中的影象和文本資訊,建立能夠自動辨識和生成表情包的應用程式。

- 教育機構使用這個資料集作為教學材料,幫助學生學習影象處理和自然語言理解的相關知識。

產品特色:

- 收集了5329個表情包,用於視覺標註和多模態學習。

- 使用 glm-4v api 和 step-free-api 進行影象解析和標註。

- 可以用於建立智慧體,提高自然語言處理和影象辨識的準確性。

- 提供了一個繪圖接口,方便使用者直接呼叫獲取表情包。

- 資料集支援多模態學習,有助於提升模型對影象和文本的理解能力。

- 提供了完整的檔案下載連結,方便使用者獲取和使用資料集。

使用教學:

訪問 emo-visual-data 的 GitHub 頁面,瞭解資料集的基本資訊和使用條件。

根據需要選擇合適的下載方式,例如透過 Google Drive 下載完整的資料集檔案。

閱讀 README 檔案,瞭解資料集的結構和如何使用資料集中的檔案。

使用 glm-free-api 繪圖接口呼叫獲取表情包,注意修改 model 引數以適應不同的需求。

將資料集應用於自己的專案中,例如訓練模型或開發應用程式。

根據專案進展和需求,不斷迭代和最佳化使用資料集的方法。