Link:https://github.com/InternLM/xtuner

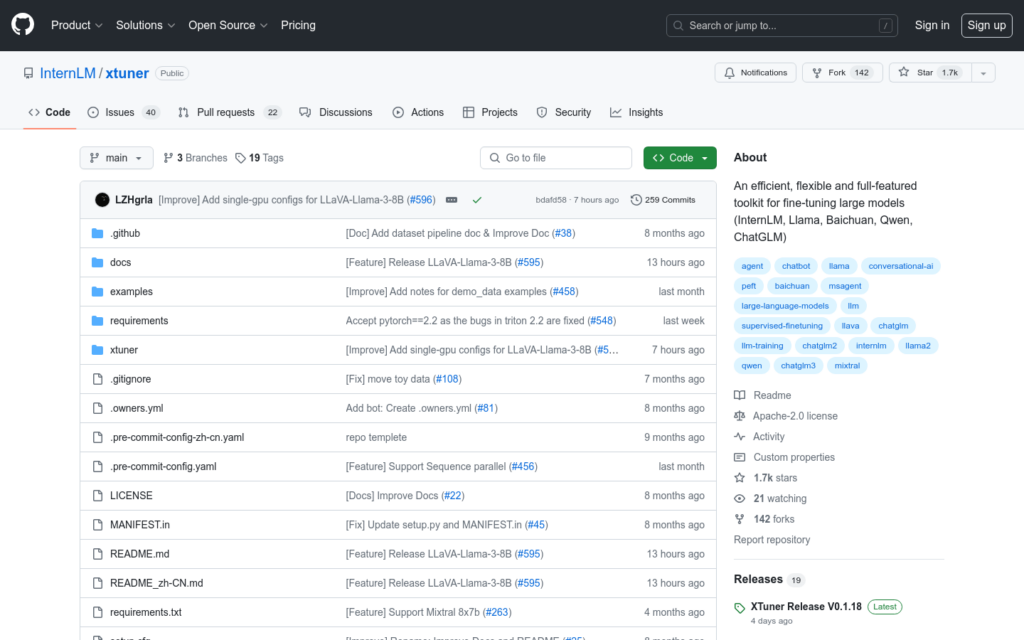

XTuner是一個為大型模型(如InternLM, Llama, Baichuan, Qwen, ChatGLM)設計的高效、靈活且功能齊全的微調工具包。它支援在幾乎所有GPU上進行LLM和VLM的預訓練和微調,能夠自動排程高效能操作,如FlashAttention和Triton核心,以提高訓練吞吐量。XTuner與DeepSpeed相容,支援多種ZeRO最佳化技術。它還支援各種LLMs和VLM(如LLaVA),並設計了良好的資料管道,能夠適應任何格式的資料集。此外,XTuner支援多種訓練演算法,包括QLoRA、LoRA和全引數微調,使使用者能夠選擇最適合其需求的解決方案。

需求人群:

“適用於需要對大型機器學習模型進行微調和最佳化的開發者和資料科學家。”

使用場景示例:

使用XTuner對InternLM2模型進行單GPU微調

在多節點環境中使用XTuner進行超過70B模型的微調

利用XTuner的QLoRA演算法對ChatGLM3模型進行微調

產品特色:

支援大型語言模型(LLM)和視覺語言模型(VLM)的預訓練和微調

自動排程高效能操作

與DeepSpeed相容,支援ZeRO最佳化技術

支援多種資料集格式

支援多種訓練演算法