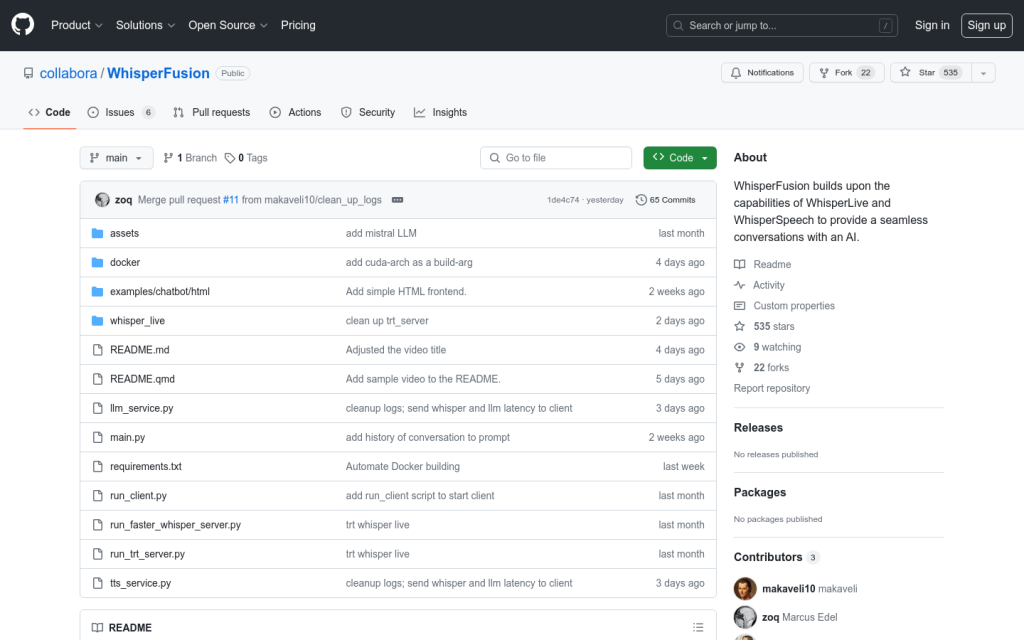

Link:whisperfusion

WhisperFusion是一款基於WhisperLive和WhisperSpeech功能的產品,透過在實時語音轉文字流程中整合Mistral大型語言模型(LLM)來實現與AI的無縫對話。Whisper和LLM均經過TensorRT引擎最佳化,以最大程度提升效能和實時處理能力。WhisperSpeech則使用torch.compile來最佳化。產品定位於提供超低延遲的AI實時對話體驗。

需求人群:

"使用者可以透過使用預構建的TensorRT-LLM Docker容器快速開始與WhisperFusion進行互動。同時,也可以構建適用於不同cuda架構的docker映象。"

使用場景示例:

1. 在網站上與WhisperFusion的AI進行實時對話

2. 透過WhisperFusion的小程式進行語音轉文字互動

3. 使用WhisperFusion外掛在桌面客戶端上進行實時語音識別

產品特色:

實時語音轉文字:利用OpenAI WhisperLive實現實時語音轉文字。

大型語言模型整合:整合Mistral大型語言模型,增強對轉錄文字的理解和語境。

TensorRT最佳化:LLM和Whisper均最佳化為TensorRT引擎,確保高效能和低延遲處理。

torch.compile:WhisperSpeech使用torch.compile來加速推斷,透過將PyTorch程式碼即時編譯為最佳化核心,使PyTorch程式碼執行更快。