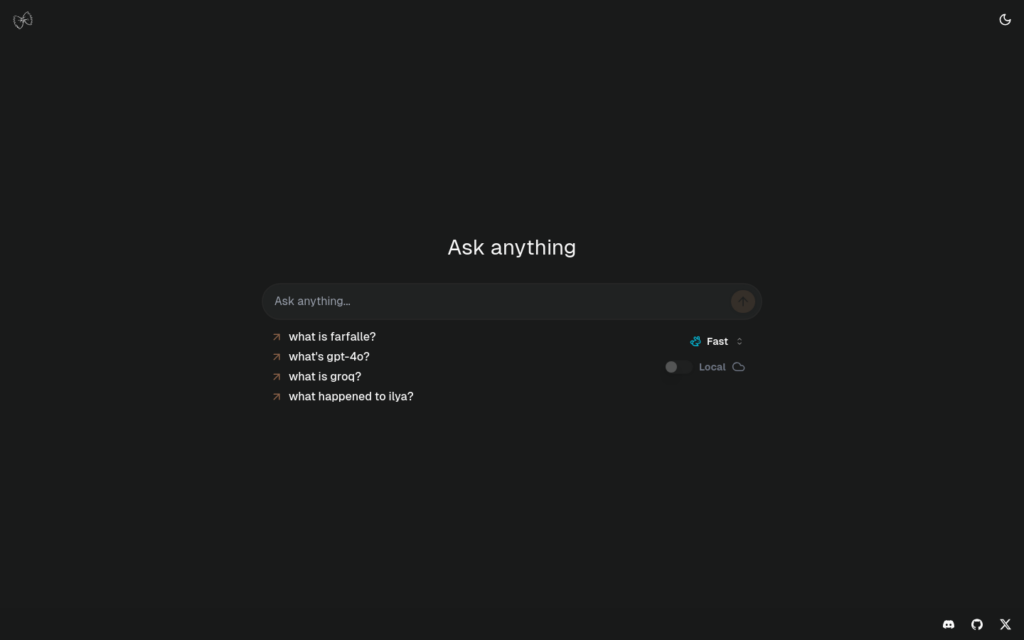

Farfalle是一個開源的AI驅動搜尋引擎,它允許使用者執行本地大型語言模型(LLMs)或使用雲模型。它是基於Perplexity克隆的,可以與多種技術棧整合,如Next.js前端、FastAPI後端、Tavily搜尋API等。它還提供了自訂設定的文檔和演示影片,以幫助使用者快速開始。

連結:https://www.farfalle.dev

需求人群:

Farfalle適合開發者和技術人員,特別是那些對AI驅動搜尋技術感興趣的人。它提供了一個開源的解決方案,使得個人和企業能夠利用大型語言模型來增強搜尋能力,無論是本地還是雲端部署。

使用場景示例:

- 開發者可以利用Farfalle建立個性化的AI搜尋引擎。

- 企業可以部署Farfalle來提供內部搜尋服務,提高員工的工作效率。

- 教育機構可以利用Farfalle作為教學工具,幫助學生更好地獲取資訊。

產品特色:

- 支援本地執行大型語言模型如llama3、gemma、mistral。

- 支援雲模型,如Groq/Llama3、OpenAI/gpt4-o。

- 提供Docker部署設定,方便使用者部署。

- 整合了Tavily搜尋API,無需外部依賴。

- 使用Logfire進行日誌記錄。

- 使用Redis進行速率限制。

- 提供詳細的自訂設定文檔。

使用教學:

- 首先,確保全裝了Docker和Ollama(如果執行本地模型)。

- 下載支援的模型之一:llama3、mistral或gemma。

- 啟動Ollama伺服器:ollama serve。

- 獲取Tavily、OpenAI(可選)和Groq(可選)的API金鑰。

- 克隆Farfalle倉庫到本地。

- 在.env檔案中新增必要的環境變數。

- 使用Docker Compose執行容器。

- 訪問http://localhost:3000來檢視應用程式。