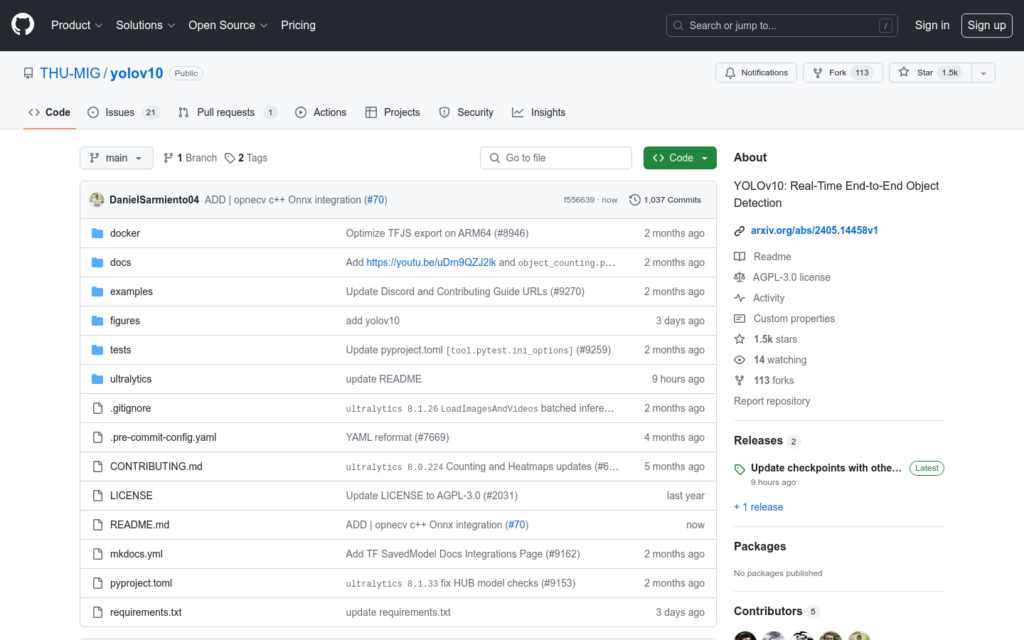

連結:https://github.com/THU-MIG/yolov10

YOLOv10是新一代的目標偵測模型,它在保持實時效能的同時,實作了高精度的目標偵測。該模型透過最佳化後處理和模型架構,減少了計算冗餘,提高了效率和效能。YOLOv10在不同模型規模上都達到了最先進的效能和效率,例如,YOLOv10-S在相似的AP下比RT-DETR-R18快1.8倍,同時引數數量和FLOPs減少了2.8倍。

需求人群:

- YOLOv10的目標受眾主要是電腦視覺領網網域的研究人員和開發者,特別是那些需要在實時環境中進行高效目標偵測的應用場景,如影片監控、自動駕駛、工業自動化等。該模型的高效率和準確性使其成為這些領網網域的理想選擇。

使用場景示例:

- 影片監控系統中實時偵測異常行為。

- 自動駕駛車輛中實時辨識行人和車輛。

- 工業生產線上自動偵測產品質量問題。

產品特色:

- 無需非極大值抑制(NMS)的一致雙重分配,實作競爭效能和低推理延遲。

- 全面最佳化的YOLOs元件,從效率和準確性兩個角度出發,大幅降低計算開銷,增強能力。

- 在COCO資料集上,YOLOv10-S、M、B、L、X不同規模模型均展現出卓越的效能。

- 支援多種解析度的輸入影象,適應不同的計算和實時性需求。

- 提供預訓練模型和訓練好的檢查點,方便使用者直接使用或進行二次開發。

- 支援多種深度學習框架,如PyTorch,方便不同背景的開發者使用。

- 提供詳細的文檔和示例程式碼,幫助使用者快速理解和應用模型。

使用教學:

1. 安裝Python環境和所需的依賴庫。

2. 克隆YOLOv10的GitHub倉庫到本地。

3. 下載預訓練模型或訓練好的檢查點。

4. 準備待偵測的影象或影片資料。

5. 執行模型進行目標偵測,獲取偵測結果。

6. 根據需要對偵測結果進行後處理,如繪製邊界框、分類標籤等。

7. 可選地,使用自己的資料集對模型進行訓練和最佳化。