Link:upscale-a-video

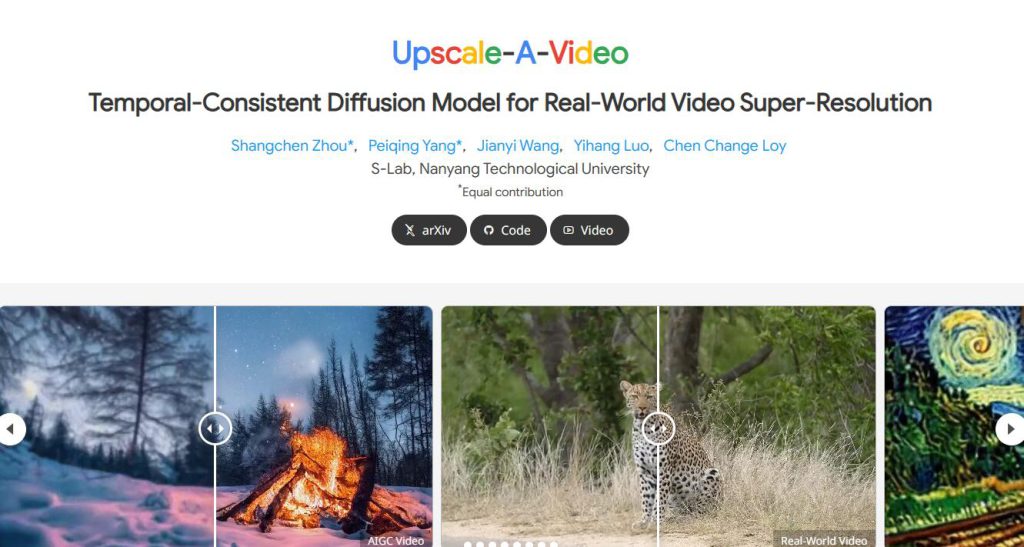

Upscale-A-Video是一個基於擴散的模型,透過將低解析度影片和文字提示作為輸入來提高影片的解析度。該模型透過兩個關鍵機制確保時間上的一致性:在區域性,它將時間層整合到U-Net和VAE-Decoder中,保持短序列的一致性;在全域性,引入了一個流引導的循環潛在傳播模組,透過在整個序列中傳播和融合潛在資訊來增強整體影片的穩定性。由於擴散正規化,我們的模型還透過允許文字提示指導紋理建立和可調噪聲水平來平衡恢復和生成,實現了保真度和質量之間的權衡。大量實驗證明,Upscale-A-Video在合成和真實世界基準以及AI生成的影片中均超越了現有方法,展現出令人印象深刻的視覺逼真和時間一致性。

需求人群:

"適用於需要提高影片解析度並保持時間一致性的場景"

使用場景示例:

用於提高老電影片段的影片質量

用於提高真實世界影片的解析度

用於提高動畫影片的視覺質量

產品特色:

透過區域性和全域性策略處理長影片,以保持時間上的一致性

使用U-Net和時間層處理影片段,以實現段內一致性

使用循環潛在傳播模組增強段間一致性

使用經過微調的VAE-Decoder減少剩餘閃爍偽影,以保持低階一致性