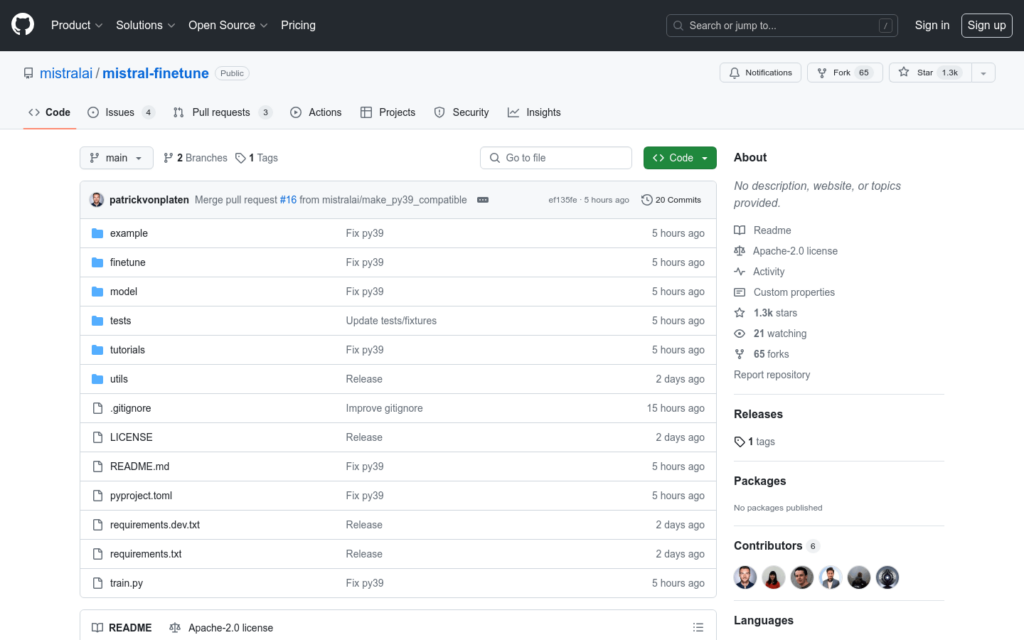

連結:https://github.com/mistralai/mistral-finetune

mistral-finetune是一個輕量級的程式碼庫,它基於LoRA訓練範式,允許在凍結大部分權重的情況下,只訓練1-2%的額外權重,以低秩矩陣微擾的形式進行微調。它被最佳化用於多GPU單節點訓練設定,對於較小模型,例如7B模型,單個GPU就足夠了。該程式碼庫旨在提供簡單、有指導意義的微調入口,特別是在資料格式化方面,並不旨在涵蓋多種模型架構或硬體型別。

需求人群:

目標受眾為需要對大型語言模型進行微調的研究人員和開發人員。該產品適合他們,因為它提供了一個輕量級、高效的微調解決方案,尤其適用於資源有限或需要特定功能定製的場景。

使用場景示例:

- 研究人員使用mistral-finetune微調7B模型,以適應特定的對話系統。

- 開發人員利用該庫為聊天機器人新增新功能,透過微調模型來理解使用者查詢。

- 教育機構使用mistral-finetune對學生提交的論文進行自動評分,提高評分效率。

產品特色:

- 支援基於LoRA的訓練範式,只訓練模型中的一小部分權重。

- 推薦使用A100或H100 GPU以獲得最大效率。

- 程式碼庫最佳化了多GPU單節點訓練配置。

- 提供了詳細的安裝和使用指南,包括依賴安裝、模型下載、資料準備等。

- 嚴格的訓練資料格式要求,支援jsonl格式資料檔案。

- 支援對話資料和指令跟隨資料的訓練。

- 提供了資料驗證和格式化工具,確保資料正確性。