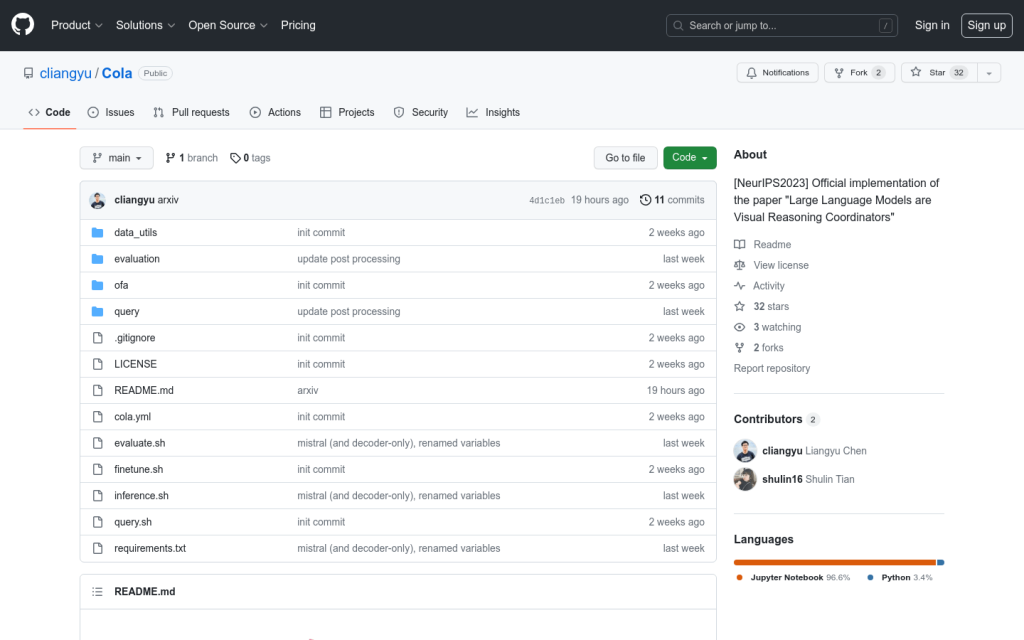

Link:cola

Cola是一種使用語言模型(LM)來聚合2個或更多視覺-語言模型(VLM)輸出的方法。我們的模型組裝方法被稱為Cola(COordinative LAnguage model or visual reasoning)。Cola在LM微調(稱為Cola-FT)時效果最好。Cola在零樣本或少樣本上下文學習(稱為Cola-Zero)時也很有效。除了效能提升外,Cola還對VLM的錯誤更具魯棒性。我們展示了Cola可以應用於各種VLM(包括大型多模態模型如InstructBLIP)和7個資料集(VQA v2、OK-VQA、A-OKVQA、e-SNLI-VE、VSR、CLEVR、GQA),並且它始終提高了效能。

需求人群:

"適用於各種視覺-語言任務,如視覺問答、影象描述等"

使用場景示例:

使用Cola-Zero進行視覺問答

使用Cola-FT進行影象描述

使用Cola提高VLM效能

產品特色:

使用語言模型聚合多個視覺-語言模型的輸出

支援LM微調和零樣本學習

提高效能並增強對VLM錯誤的魯棒性