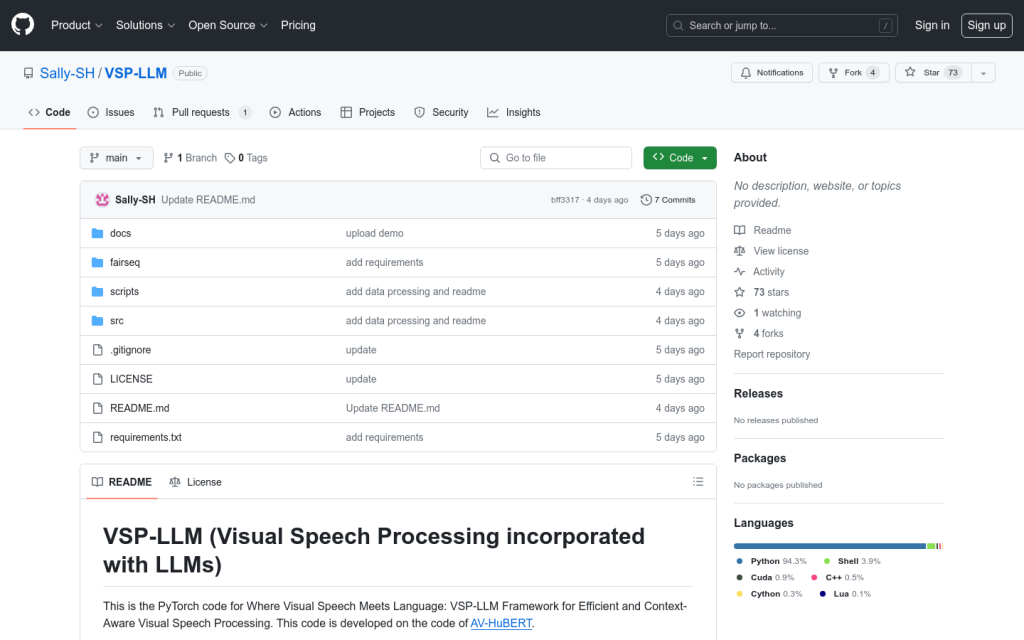

Link:vsp-llm

VSP-LLM是一個結合視覺語音處理(Visual Speech Processing)與大型語言模型(LLMs)的框架,旨在透過LLMs的強大能力最大化上下文建模能力。VSP-LLM設計用於執行視覺語音識別和翻譯的多工,透過自監督視覺語音模型將輸入影片對映到LLM的輸入潛在空間。該框架透過提出一種新穎的去重方法和低秩介面卡(LoRA),可以高效地進行訓練。

需求人群:

["多語言語音識別","跨語言影片內容理解","實時語音翻譯"]

使用場景示例:

在多語言環境中,使用VSP-LLM進行實時語音翻譯

利用VSP-LLM分析影片內容,提取關鍵資訊並生成摘要

在教育應用中,使用VSP-LLM輔助語言學習,提高語音識別準確性

產品特色:

視覺語音識別

視覺語音翻譯

自監督學習

去重和低秩介面卡訓練