Link:intrinsicanything

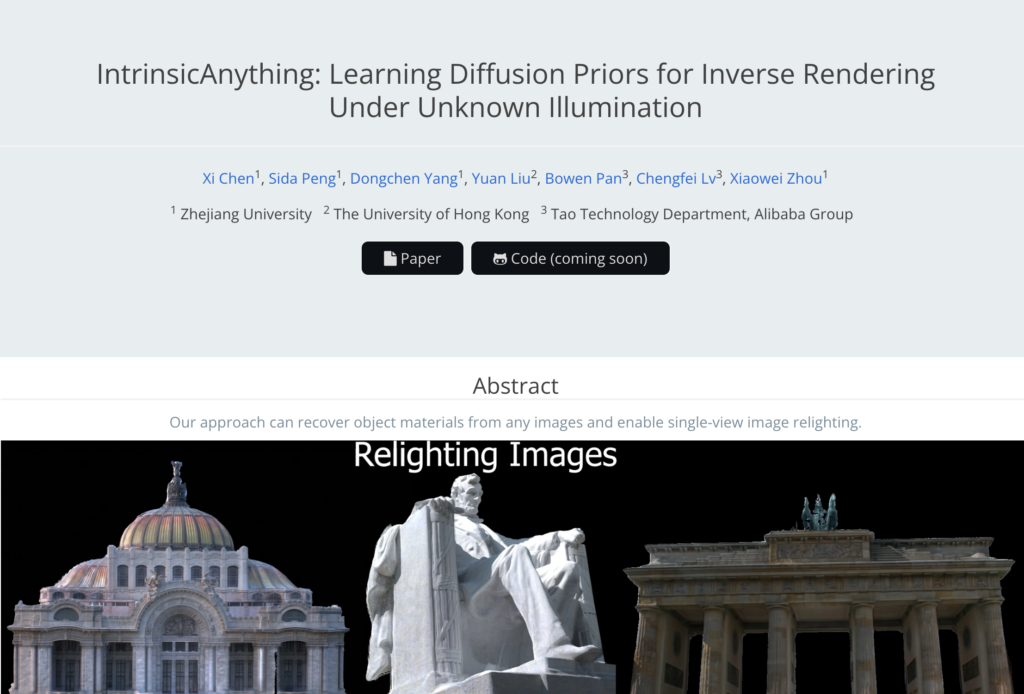

IntrinsicAnything 是一種先進的影象逆渲染技術,它透過學習擴散模型來最佳化材質恢復過程,解決了在未知靜態光照條件下捕獲的影象中物體材質恢復的問題。該技術透過生成模型學習材質先驗,將渲染方程分解為漫反射和鏡面反射項,利用現有豐富的3D物體資料進行訓練,有效地解決了逆渲染過程中的歧義問題。此外,該技術還開發了一種從粗到細的訓練策略,利用估計的材質引導擴散模型產生多視圖一致性約束,從而獲得更穩定和準確的結果。

需求人群:

["適用於影象處理領網域的專業人士","適合進行3D建模和渲染的研究者","對於需要從影象中提取材質資訊的設計師","可以用於教育領網域,作為逆渲染技術的教學工具"]

使用場景示例:

使用IntrinsicAnything從歷史建築的照片中恢復其材質,以進行數位化重建

在電影製作中,利用該技術從實際拍攝的影象中恢復材質,用於特效製作

在遊戲開發中,使用該技術從參考影象中恢復材質,以提高遊戲內物體的真實感

產品特色:

從任意影象中恢復物體材質

實作單視圖影象重照明

透過神經網路表示材質並最佳化模型引數

使用擴散模型對漫反射和鏡面反射進行建模

利用現有3D物體資料進行訓練

多視圖一致性約束以提高恢復的穩定性和準確性

在真實世界和合成資料集上的廣泛實驗驗證