連結:https://www.superclueai.com

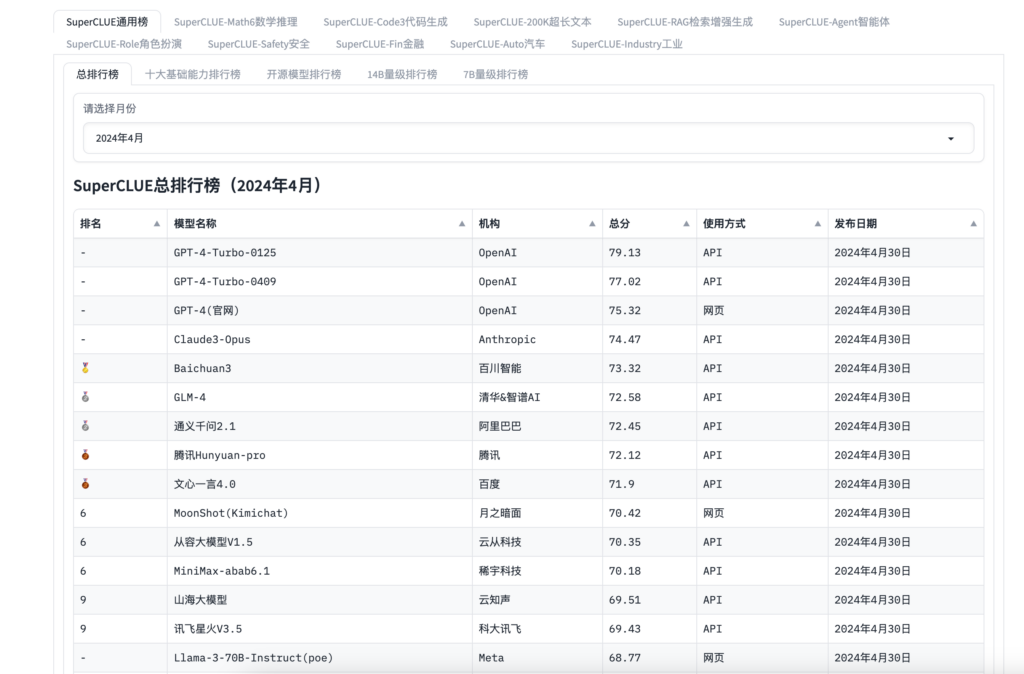

SuperCLUE是一個用於評估和比較大型語言模型效能的線上平臺。它提供了多種任務和排行榜,旨在為AI研究者和開發者提供一個標準化的測試環境。SuperCLUE支援各種AI應用場景,包括數學推理、程式碼生成、超長文本處理等,能夠幫助使用者準確評估模型在不同任務上的表現和能力。

需求人群:

- SuperCLUE面向AI領網網域的研究者、開發者以及企業使用者,尤其是那些專注於開發和最佳化大型語言模型的團隊。透過SuperCLUE,他們可以有效地測試和驗證自己模型的效能,與全球範圍內的其他模型進行比較,從而不斷提升模型的能力,並在AI領網網域保持競爭力。

使用場景示例:

- 研究者使用SuperCLUE評測其最新開發的AI模型在數學推理任務上的表現。

- 企業透過SuperCLUE對比不同AI模型在程式碼生成任務中的效能,以選擇最適合的模型整合到產品中。

- AI開發者利用SuperCLUE的API接口,實作模型效能的自動化測試和監控。

產品特色:

- 提供多種AI模型效能評測任務,如數學推理、程式碼生成等

- 支援使用者提交模型結果,參與排行榜競爭

- 詳細的評測報告,幫助使用者瞭解模型在各項任務上的表現

- 提供API接口,方便使用者整合和自動化測試

- 定期更新任務和排行榜,保持評測的時效性和挑戰性

- 支援不同量級的模型評測,如14B量級、7B量級等

使用教學:

訪問SuperCLUE官網並註冊賬戶

選擇感興趣的評測任務,瞭解任務要求和評測標準

準備模型並根據要求提交結果

檢視評測報告,分析模型在各項任務上的表現

根據需要參與排行榜競爭或使用API進行自動化測試