連結:https://github.com/togethercomputer/moa

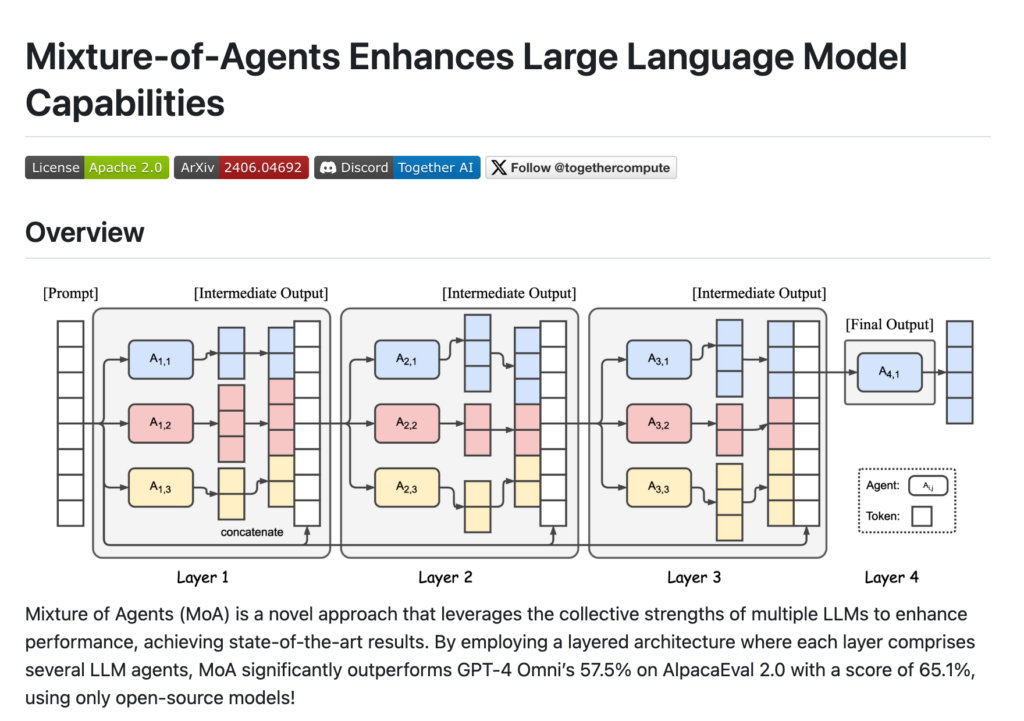

MoA(Mixture of Agents)是一種新穎的方法,它利用多個大型語言模型(LLMs)的集體優勢來提升效能,實作了最先進的結果。MoA採用分層架構,每層包含多個LLM代理,顯著超越了GPT-4 Omni在AlpacaEval 2.0上的57.5%得分,達到了65.1%的得分,使用的是僅開源模型。

需求人群:

- MoA主要面向AI研究人員和開發者,特別是那些專注於提升語言模型效能和尋求開源解決方案的專業人士。MoA的技術背景和主要優點使其成為希望在自然語言處理領網網域取得突破的研究者和開發者的理想選擇。

使用場景示例:

- 在AlpacaEval 2.0上實作7.6%的絕對提升

- 在FLASK評估中,在無害性、魯棒性等多個維度上超越GPT-4 Omni

- 透過自訂配置實作個性化的多輪對話體驗

產品特色:

- 透過多層代理架構增強語言模型效能

- 在AlpacaEval 2.0上實作65.1%的得分,超越GPT-4 Omni

- 支援多輪對話,保持上下文連貫性

- 提供自訂配置,包括聚合器、參考模型、溫度等引數

- 提供腳本快速復現論文中的結果

- 在FLASK評估中,在多個維度上顯著超越原始模型

使用教學:

1. 匯出Together API金鑰並設定為環境變數

2. 安裝所需的依賴項

3. 執行互動式演示腳本並輸入指令

4. 系統將使用預定義的參考模型處理輸入

5. 根據聚合模型的輸出生成響應

6. 透過輸入更多指令繼續多輪對話,系統將維持對話上下文

7. 輸入’exit’退出聊天機器人