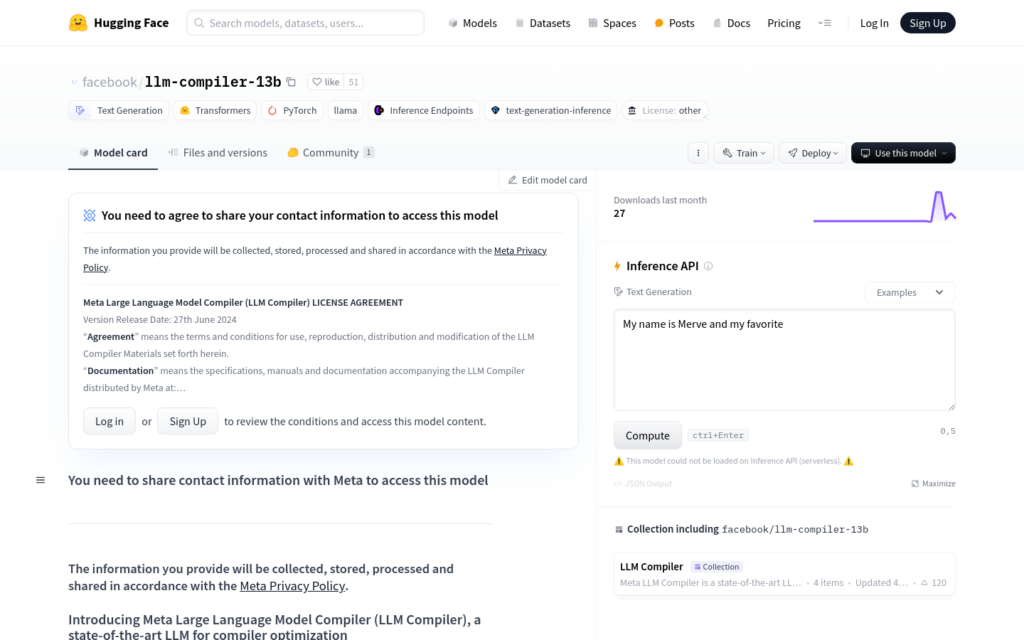

連結:https://huggingface.co/facebook/llm-compiler-13b

Meta Large Language Model Compiler (LLM Compiler-13b) 是基於Code Llama構建的,專注於程式碼最佳化和編譯器推理的先進大型語言模型。它在編譯器最佳化任務上展現出比現有公開可用的大型語言模型更強的理解能力,能夠完美模擬編譯器輸出20%的時間。LLM Compiler提供了兩種模型尺寸:7B和13B引數,針對不同的服務和延遲需求進行了訓練。該模型是免費的,適用於研究和商業用途,旨在支援編譯器研究人員和工程師,並激發創新工具的開發。

需求人群:

- LLM Compiler的目標受眾是編譯器研究人員、工程師以及希望提高程式碼效率和減小程式體積的開發者。該技術能夠幫助他們透過自動化的方式進行程式碼最佳化,減少手動最佳化的工作量,同時提高編譯器輸出的準確性和效率。

使用場景示例:

- 使用LLM Compiler對大型軟體專案進行程式碼最佳化,減少最終程式的體積。

- 在編譯器開發過程中,利用LLM Compiler預測不同最佳化策略對程式碼效能的影響。

- 在教育領網網域,作為教學工具,幫助學生理解編譯器最佳化的原理和效果。

產品特色:

- 預測LLVM最佳化對程式碼大小的影響

- 生成最小化程式碼大小的最佳化傳遞列表

- 從x86_64或ARM彙程式設計式碼生成LLVM IR

- 在編譯器最佳化任務中實作高精度的程式碼模擬

- 提供7B和13B引數的模型以滿足不同延遲需求

- 透過深度學習最佳化程式碼,提高程式效率和減小程式大小

使用教學:

安裝必要的庫和依賴,例如transformers。

從Hugging Face下載所需的LLM Compiler模型。

使用AutoTokenizer從預訓練模型中載入分詞器。

設定transformers.pipeline進行文本生成,配置適當的引數。

透過pipeline輸入待最佳化的程式碼片段,獲取模型生成的最佳化建議。

根據模型輸出的結果,對程式碼進行調整和最佳化。

對最佳化後的程式碼進行測試,確保最佳化效果符合預期。