Link:actanywhere

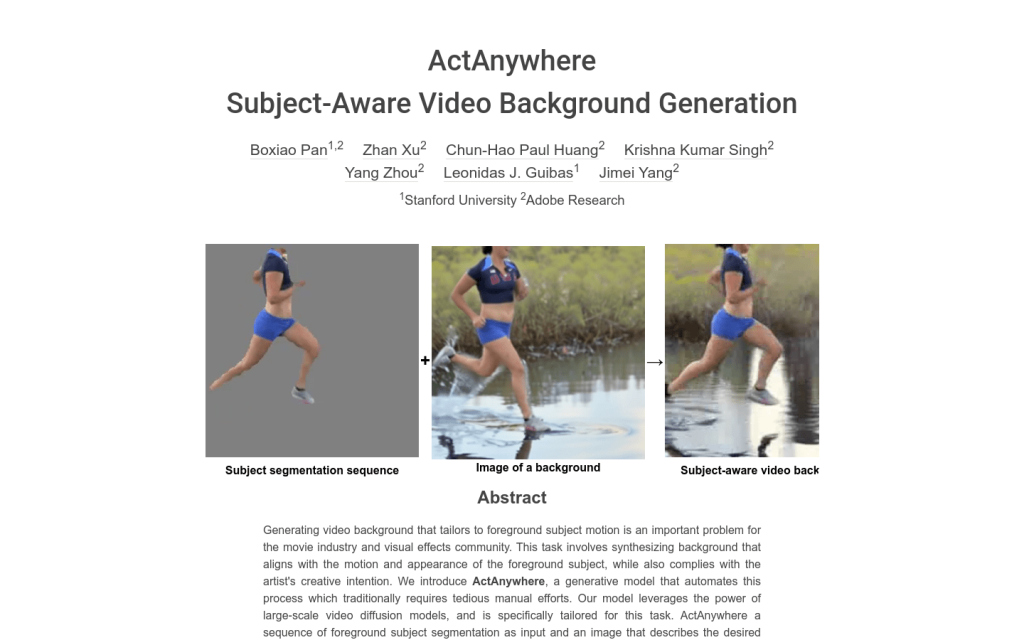

ActAnywhere是一個用於自動生成與前景主體運動和外觀相符的影片背景的生成模型。該任務涉及合成與前景主體運動和外觀相一致的背景,同時也符合藝術家的創作意圖。ActAnywhere利用大規模影片擴散模型的力量,並專門定製用於此任務。ActAnywhere以一系列前景主體分割作為輸入,以描述所需場景的影象作為條件,生成與條件幀相一致的連貫影片,同時實現現實的前景和背景互動。該模型在大規模人機互動影片資料集上進行訓練。大量評估表明該模型的效能明顯優於基準,可以泛化到各種分佈樣本,包括非人類主體。

需求人群:

"ActAnywhere可用於自動為包含人類或其他主體的影片生成相應的背景,從而減少手工調整的工作量,提高影片製作效率。"

使用場景示例:

– 使用包含人物運動的影片分割序列及海邊圖片,生成人物在海邊奔跑的合成影片

– 使用包含舞蹈動作的影片分割和古代宮殿的圖片,生成舞蹈在宮殿裡進行的效果

– 使用汽車行駛的影片分割和高樓大廈的圖片,生成汽車在城市街景行駛的效果

產品特色:

– 根據輸入的前景主體分割序列,可以生成符合條件影象的影片背景

– 生成的背景會與前景主體運動和外觀相協調

– 支援以合成的包含主體的幀或者僅包含背景的幀作為條件影象

– 可以生成具有不同攝像機運動的影片背景