Link:tinyllama

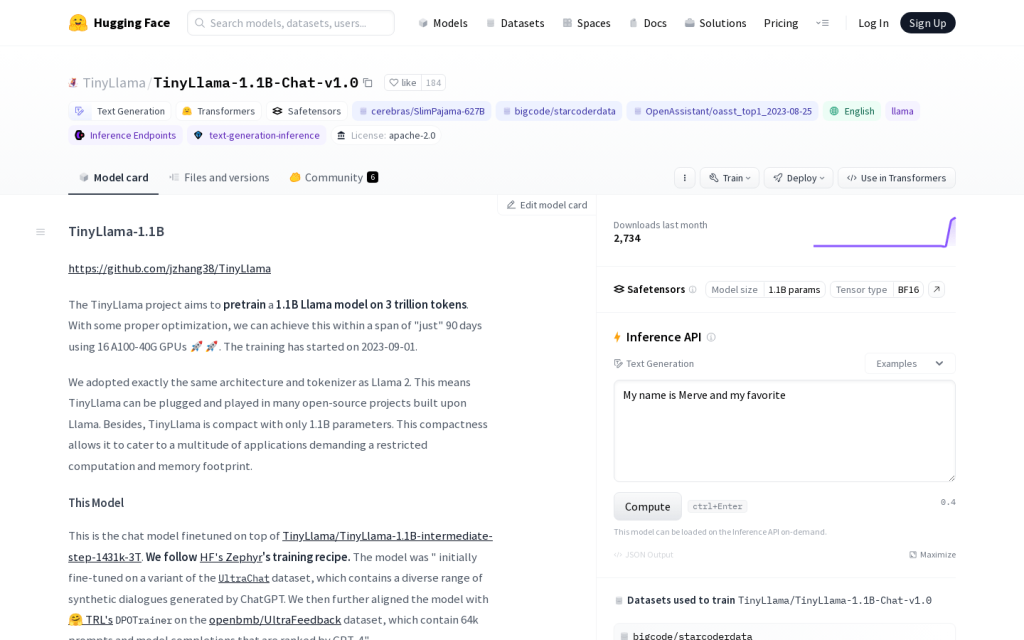

TinyLlama專案旨在在3萬億令牌上預訓練一個1.1B Llama模型。透過一些適當的最佳化,我們可以在“僅”90天內使用16個A100-40G GPU完成。訓練已於2023-09-01開始。我們採用了與Llama 2完全相同的架構和分詞器。這意味著TinyLlama可以在許多建立在Llama基礎上的開源專案中使用。此外,TinyLlama只有1.1B個引數,緊湊性使其能夠滿足許多對計算和記憶體佔用有限的應用需求。

需求人群:

"TinyLlama可用於聊天模型的微調和文字生成。"

使用場景示例:

https://github.com/jzhang38/TinyLlama

https://huggingface.co/docs/transformers/main/en/chat_templating

https://github.com/huggingface/transformers.git

產品特色:

文字生成

Transformers

安全張量