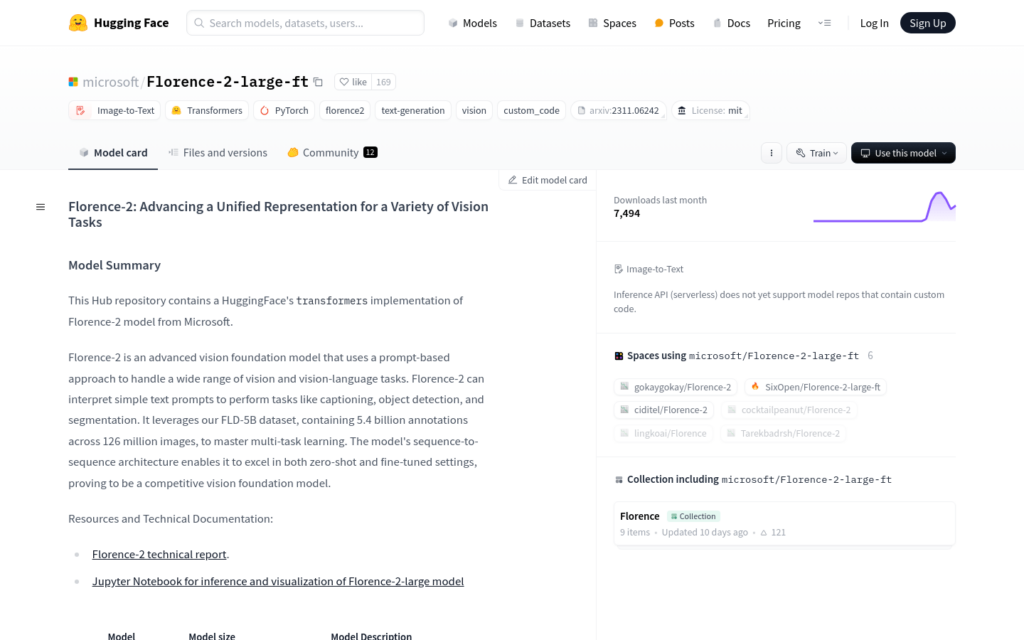

連結:https://huggingface.co/microsoft/Florence-2-large-ft

Florence-2-large-ft是由微軟開發的高階視覺基礎模型,使用基於提示的方法來處理廣泛的視覺和視覺-語言任務。該模型能夠透過簡單的文本提示執行諸如影象描述、目標偵測和分割等任務。它利用FLD-5B資料集,包含54億個註釋,覆蓋1.26億張影象,實作多工學習。模型的序列到序列架構使其在零樣本和微調設定中均表現出色,證明其為有競爭力的視覺基礎模型。

需求人群:

“目標受眾為需要進行影象處理和分析的研究人員和開發者,包括但不限於電腦視覺、自然語言處理和機器學習領網網域的專業人士。該產品適合他們因為它提供了一個強大的工具來處理複雜的視覺任務,並且能夠透過簡單的文本提示來實作任務的自動化。”

使用場景示例:

研究人員使用Florence-2-large-ft模型自動生成影象描述,以輔助視覺障礙人士理解影象內容。

開發者利用該模型進行目標偵測,以提高自動駕駛車輛的感知能力。

企業使用該技術進行產品影象的自動標註和分類,以最佳化電子商務平臺的搜尋和推薦系統。

產品特色:

影象描述:生成影象的文本描述。

目標偵測:辨識並定時陣影象中的目標。

分割:將影象分割成不同的區網網域或對象。

區網網域提議:生成影象中可能包含目標的區網網域。

OCR:辨識影象中的文字。

區網網域OCR:辨識特定區網網域中的文字。

使用教學:

1. 安裝必要的庫,如transformers和PIL。

2. 使用AutoModelForCausalLM和AutoProcessor從Hugging Face模型庫中載入Florence-2-large-ft模型和處理器。

3. 準備輸入資料,包括文本提示和影象。

4. 透過處理器將文本和影象轉換為模型可接受的格式。

5. 使用模型的generate方法生成輸出。

6. 使用處理器的batch_decode方法將生成的ID轉換迴文本。

7. 根據任務型別,使用後處理函式解析生成的文本。

8. 輸出最終結果,如影象描述或目標偵測的邊界框和標籤。