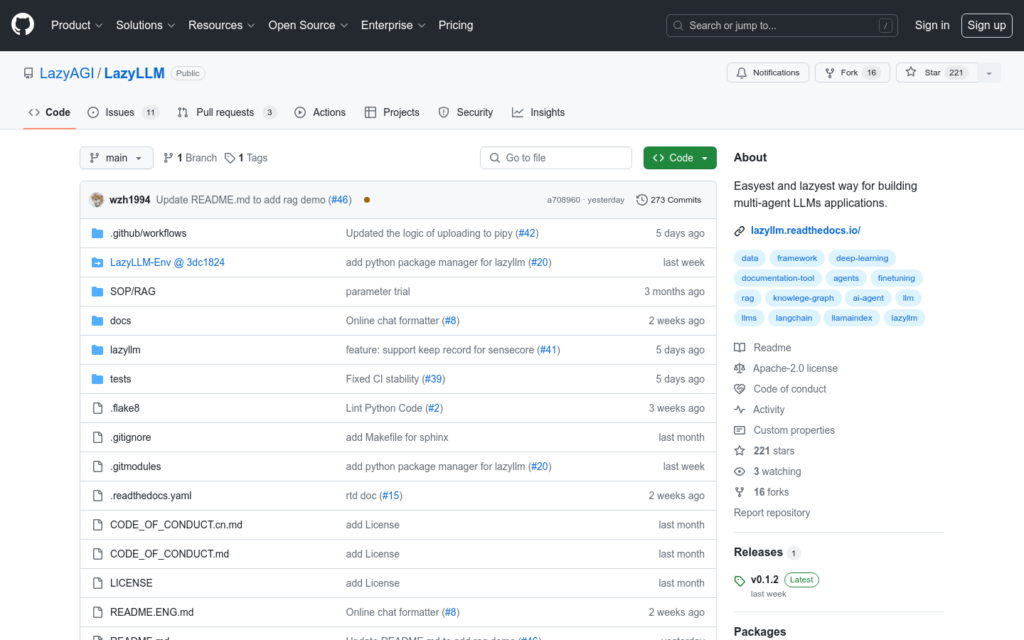

連結:https://github.com/LazyAGI/LazyLLM

LazyLLM是一個致力於簡化人工智慧應用構建流程的開發工具,它透過提供低程式碼的解決方案,使得開發者即使不瞭解大模型也能輕鬆組裝包含多個Agent的AI應用。LazyLLM支援一鍵部署所有模組,跨平臺相容,自動進行網格搜尋引數最佳化,以及高效的模型微調,從而提升應用效果。

需求人群:

- LazyLLM的目標受眾是演演算法研究員和開發者,尤其是那些希望從繁雜的工程實作中解脫出來,專注於演演算法和資料的專業人士。無論是初學者還是資深專家,LazyLLM都能提供幫助,簡化AI應用的構建過程,讓開發者能夠集中精力提升演演算法效果。

使用場景示例:

- 構建對話機器人,實作與使用者的多輪對話。

- 實作檢索增強生成,結合檢索結果和生成模型提供更準確的回答。

- 故事創作,根據使用者提供的大綱自動生成故事內容。

產品特色:

- 便捷的AI應用組裝流程,像搭積木一樣簡單。

- 複雜應用一鍵部署,簡化多Agent應用的部署流程。

- 跨平臺相容,無需修改程式碼,一鍵切換IaaS平臺。

- 支援網格搜尋引數最佳化,自動嘗試不同配置,快速找到最佳配置。

- 高效的模型微調,根據場景自動選擇微調框架和模型切分策略。

- 提供基礎的介面支援,如聊天介面、文檔管理介面等。

使用教學:

1. 安裝LazyLLM,透過原始碼或pip安裝。

2. 設定環境變數或設定檔,以便LazyLLM訪問所需的API服務。

3. 根據需求匯入LazyLLM中的模組和元件。

4. 利用LazyLLM提供的元件和模組,組裝AI應用。

5. 使用LazyLLM的Flow功能,定義資料流和工作流。

6. 進行應用的部署和測試,確保功能符合預期。

7. 根據反饋進行模型微調和引數最佳化,提升應用效果。