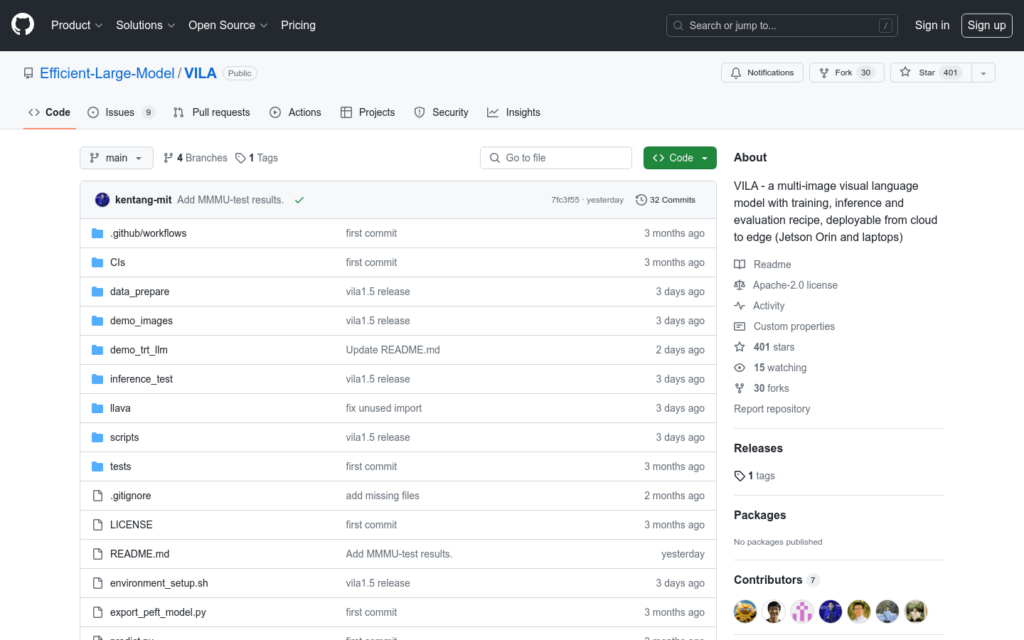

Link:vila

VILA是一個預訓練的視覺語言模型(VLM),它透過大規模的交錯影象-文本資料進行預訓練,從而實作影片理解和多影象理解能力。VILA透過AWQ 4bit量化和TinyChat框架在邊緣設備上可部署。主要優點包括:1) 交錯影象-文本資料對於提升效能至關重要;2) 在交錯影象-文本預訓練期間不凍結大型語言模型(LLM)可以促進上下文學習;3) 重新混合文本指令資料對於提升VLM和純文本效能至關重要;4) 標記壓縮可以擴充影片幀數。VILA展示了包括影片推理、上下文學習、視覺思維鏈和更好的世界知識等引人入勝的能力。

需求人群:

[“研究人員和開發者:可以利用VILA進行影片理解和多影象理解相關的研究和應用開發。”,”企業使用者:在需要影片內容分析和理解的商業場景中,如安全監控、內容推薦等,VILA可以提供強大的技術支援。”,”教育領網域:VILA可以作為教學工具,幫助學生更好地理解視覺語言模型的工作原理和應用場景。”]

使用場景示例:

使用VILA進行影片內容的自動標註和分析。

在教育平臺中整合VILA,提供影象和影片的智慧解讀功能。

將VILA應用於智慧安防系統,進行實時影片監控和異常行為偵測。

產品特色:

影片理解能力:VILA-1.5版本提供了影片理解功能。

多模型尺寸:提供3B/8B/13B/40B四種模型尺寸。

高效部署:透過AWQ量化的4bit VILA-1.5模型,可在多種NVIDIA GPU上高效部署。

上下文學習:在交錯影象-文本預訓練期間不凍結LLM,促進上下文學習。

標記壓縮:透過標記壓縮技術擴充影片幀數,提升模型效能。

開原始碼:包括訓練程式碼、評估程式碼、資料集和模型檢查點在內的所有內容均已開源。

效能提升:透過特定技術手段,如重新混合文本指令資料,顯著提升VLM和純文本效能。