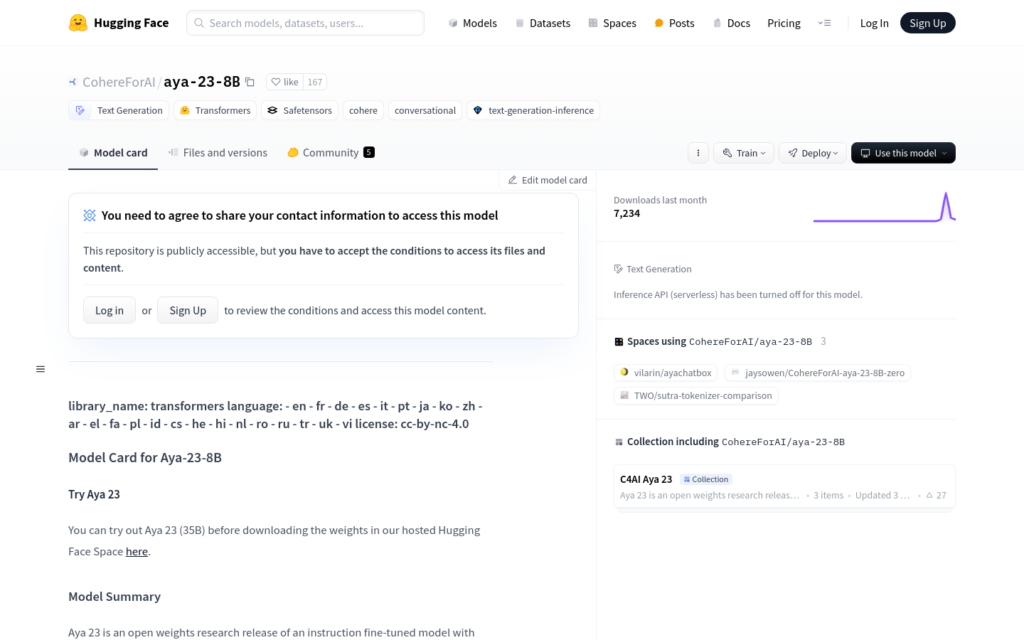

連結:https://huggingface.co/CohereForAI/aya-23-8B

Aya-23-8B是由Cohere For AI開發的指令微調模型,具有23種語言的強大多語言能力,專注於將高效能預訓練模型與Aya Collection結合,為研究人員提供高效能的多語言模型。

需求人群:

Aya-23-8B模型適用於需要處理多種語言文本生成和理解的研究人員和開發者,特別是在機器學習和自然語言處理領網網域。

使用場景示例:

- 使用Aya-23-8B生成特定語言的文本。

- 在多語言聊天機器人中整合Aya-23-8B以提供更自然的對話體驗。

- 利用Aya-23-8B進行跨語言文本分析和資料探勘。

產品特色:

- 支援23種語言,包括阿拉伯語、中文、捷克語、荷蘭語、英語、法語、德語、希臘語、希伯來語、印地語、印尼語、義大利語、日語、韓語、波斯語、波蘭語、葡萄牙語、羅馬尼亞語、俄語、西班牙語、土耳其語、烏克蘭語和越南語。

- 最佳化的transformer架構,用於自迴歸語言模型。

- 經過預訓練後,該模型進行了指令微調以遵循人類指令。

- 模型輸入文本,輸出文本生成。

- 上下文長度支援高達8192。

- 提供了詳細的使用示例和評估報告。

使用教學:

- 安裝包含該模型所需更改的transformers原始碼庫。

- 使用AutoTokenizer和AutoModelForCausalLM從預訓練模型ID載入模型。

- 格式化訊息並應用聊天範本,包括角色和內容。

- 使用模型的generate方法生成文本,設定適當的引數如max_new_tokens、do_sample和temperature。

- 解碼生成的token以獲取最終文本。

- 透過Hugging Face Space或Cohere playground線上試用Aya-23-8B模型。