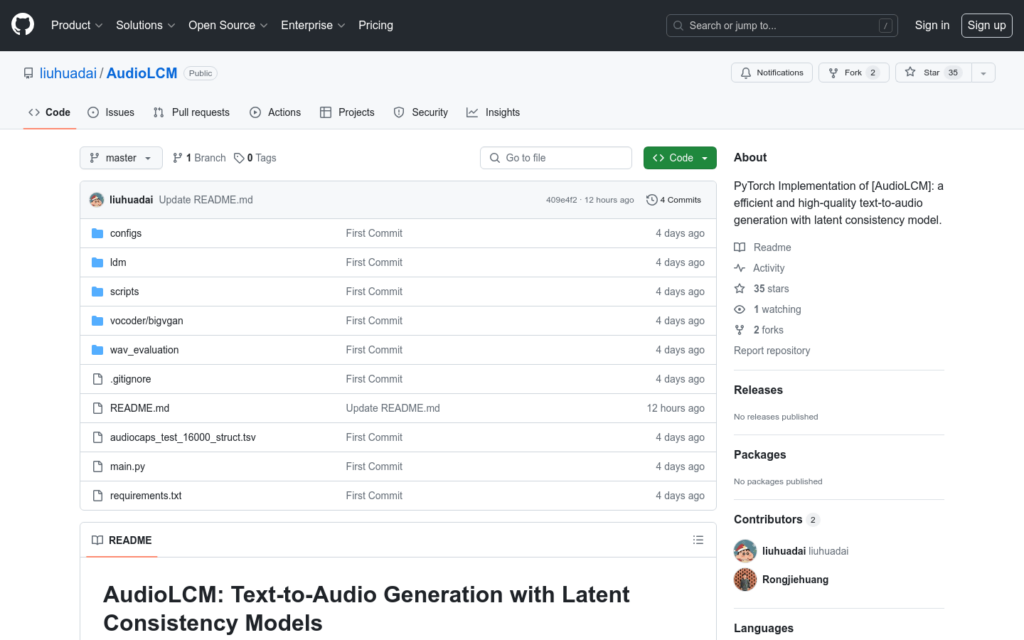

連結:https://github.com/liuhuadai/AudioLCM

AudioLCM是一個基於PyTorch實作的文本到音訊生成模型,它透過潛在一致性模型來生成高質量且高效的音訊。該模型由Huadai Liu等人開發,提供了開源的實作和預訓練模型。它能夠將文本描述轉化為接近真實的音訊,具有重要的應用價值,尤其是在語音合成、音訊製作等領網網域。

需求人群:

AudioLCM模型主要面向音訊工程師、語音合成研究者和開發者,以及對音訊生成技術感興趣的學者和愛好者。它適用於需要將文本描述自動轉化為音訊的應用場景,如虛擬助手、有聲讀物製作、語言學習工具等。

使用場景示例:

- 使用AudioLCM生成特定文本的朗讀音訊,用於有聲書或播客。

- 將歷史人物的演講稿轉化為逼真的語音,用於教育或展覽。

- 為影片遊戲或動畫角色生成定製的語音,增強角色的個性和表現力。

產品特色:

- 支援從文本到音訊的高保真度生成。

- 提供了預訓練模型,方便使用者快速開始使用。

- 允許使用者下載權重,以支援自訂資料集。

- 提供了詳細的訓練和推理程式碼,方便使用者學習和二次開發。

- 能夠處理mel頻譜圖的生成,為音訊合成提供必要的中間表示。

- 支援變分自編碼器和擴散模型的訓練,以生成高質量的音訊。

- 提供了評估工具,可以計算FD, FAD, IS, KL等音訊質量指標。

使用教學:

克隆AudioLCM的GitHub倉庫到本地機器。

根據README中的說明,準備NVIDIA GPU和CUDA cuDNN環境。

下載所需的資料集權重,並按照指導準備資料集資訊。

執行mel頻譜圖生成腳本,為音訊合成準備中間表示。

訓練變分自編碼器(VAE),以學習文本和音訊之間的潛在對映。

使用訓練好的VAE模型,訓練擴散模型以生成高質量的音訊。

使用評估工具對生成的音訊進行質量評估,如計算FD, FAD等指標。

根據個人需求,對模型進行微調和最佳化,以適應特定的應用場景。