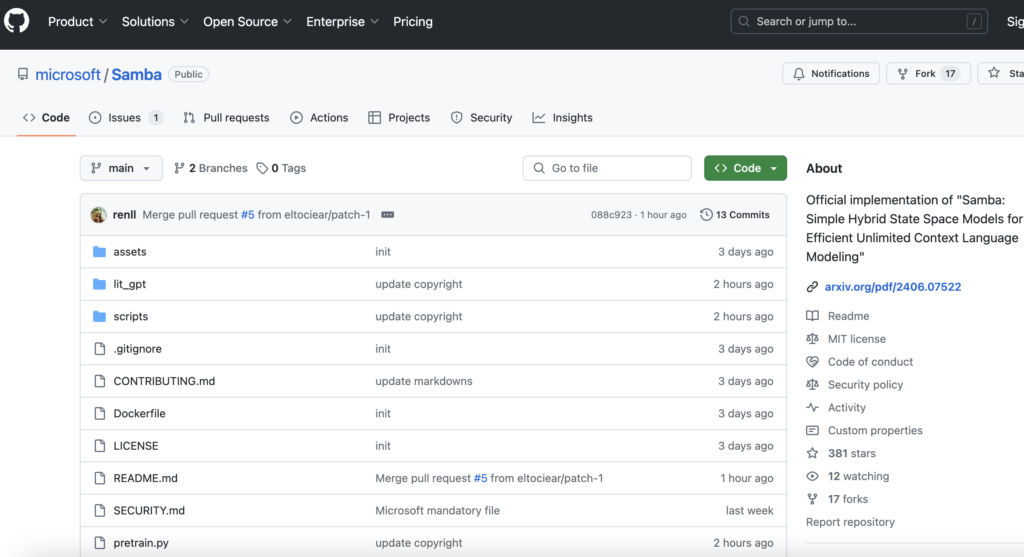

連結:https://github.com/microsoft/Samba/

Samba是一個簡單而強大的混合模型,具有無限的上下文長度。它的架構非常簡單:Samba = Mamba + MLP + 滑動視窗注意力 + 層級MLP堆疊。Samba-3.8B模型在Phi3資料集上訓練了3.2萬億個token,主要基準測試(例如MMLU、GSM8K和HumanEval)上的表現大大超過了Phi3-mini。Samba還可以透過最少的指令調整實作完美的長上下文檢索能力,同時保持與序列長度的線性複雜度。這使得Samba-3.8B-instruct在下游任務(如長上下文摘要)上表現出色。

需求人群:

- Samba模型主要面向自然語言處理和機器學習領網網域的研究人員和開發者。它適合需要處理大量文本資料、進行復雜語言模型訓練和評估的使用者。Samba的長上下文處理能力和高效的計算效能,使其成為研究和開發先進語言模型的理想選擇。

使用場景示例:

- 研究人員使用Samba模型在長文本摘要任務中取得了突破性進展。

- 開發者利用Samba進行大規模語言模型的訓練和最佳化,提高了模型效能。

- 教育機構採用Samba作為教學工具,幫助學生理解複雜的語言模型架構和訓練過程。

產品特色:

- Samba模型具有無限的上下文長度,可以處理長文本資料。

- 透過混合模型架構,結合了Mamba、MLP和滑動視窗注意力機制。

- Samba-3.8B模型在多個基準測試中表現出色,超越了Phi3-mini。

- 模型可以在極少的指令調整下實作長上下文檢索能力。

- 保持與序列長度的線性複雜度,適合大規模語言模型訓練。

- 提供了詳細的訓練指南和環境設定說明。

- 支援自訂模型架構配置,易於實驗和研究。

使用教學:

1. 根據Dockerfile設定環境,確保系統滿足Samba模型的執行要求。

2. 下載並準備SlimPajama資料集,按照指南進行資料預處理。

3. 修改設定檔,根據需要選擇不同的模型架構和訓練引數。

4. 使用提供的腳本啟動訓練過程,監控模型訓練狀態和效能。

5. 根據實驗結果調整模型引數,最佳化模型效能。

6. 利用訓練好的模型進行下游任務的測試和應用。