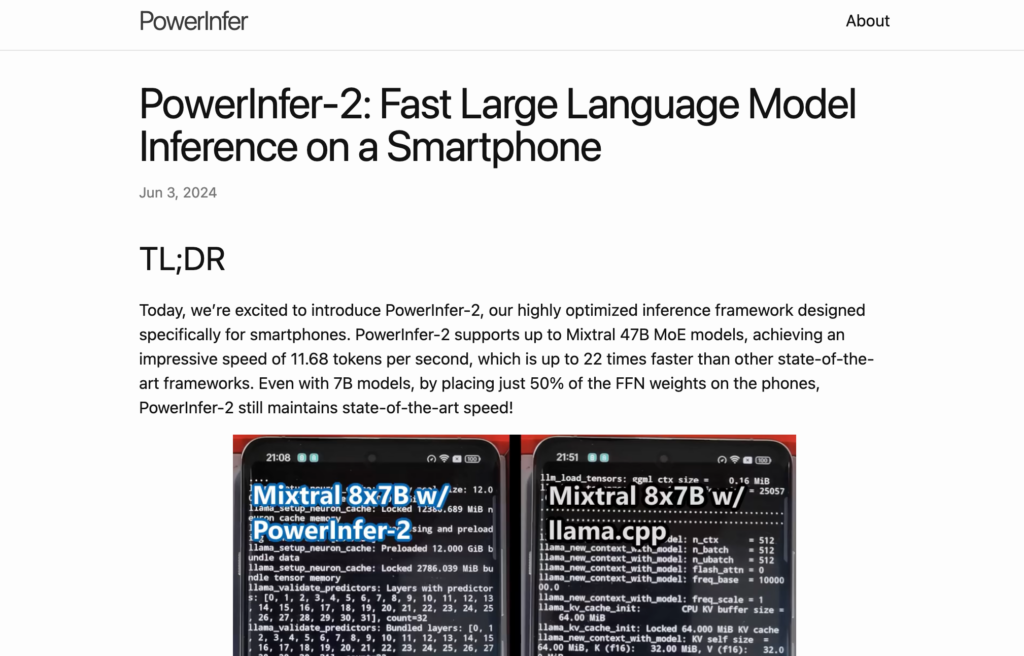

PowerInfer-2是一個為智慧型行動電話特別最佳化的推理框架,支援高達47B引數的MoE模型,實作了每秒11.68個token的推理速度,比其他框架快22倍。它透過異構計算和I/O-Compute流水線技術,顯著減少了記憶體使用,並提高了推理速度。該框架適用於需要在行動裝置上部署大型模型的場景,以增強資料隱私和效能。

需求人群:

- 目標受眾為需要在行動裝置上部署大型語言模型的開發者和企業。他們可以利用PowerInfer-2的高速推理能力,開發出效能優越、資料隱私保護更強的移動應用。

使用場景示例:

- 移動應用開發者使用PowerInfer-2在智慧型行動電話上部署個性化推薦系統

- 企業利用PowerInfer-2在行動裝置上實作客戶服務自動化

- 研究機構使用PowerInfer-2在行動裝置上進行實時語言翻譯和互動

產品特色:

- 支援高達47B引數的MoE模型

- 實作每秒11.68個token的推理速度

- 異構計算最佳化,動態調整計算單元大小

- I/O-Compute流水線技術,最大化資料載入與計算的重疊

- 顯著減少記憶體使用,提高推理速度

- 適用於智慧型行動電話,增強資料隱私和效能

- 模型系統共同設計,確保模型的可預測稀疏性

使用教學:

1. 訪問PowerInfer-2的官方網站並下載框架

2. 根據文檔說明,整合PowerInfer-2到移動應用開發專案中

3. 選擇適合的模型並配置模型引數,確保模型的稀疏性

4. 利用PowerInfer-2的API進行模型推理,最佳化推理速度和記憶體使用

5. 在行動裝置上測試推理效果,確保應用效能和使用者體驗

6. 根據反饋進行調整,最佳化模型部署和推理過程