ALMA-13B-R:先進的機器翻譯模型

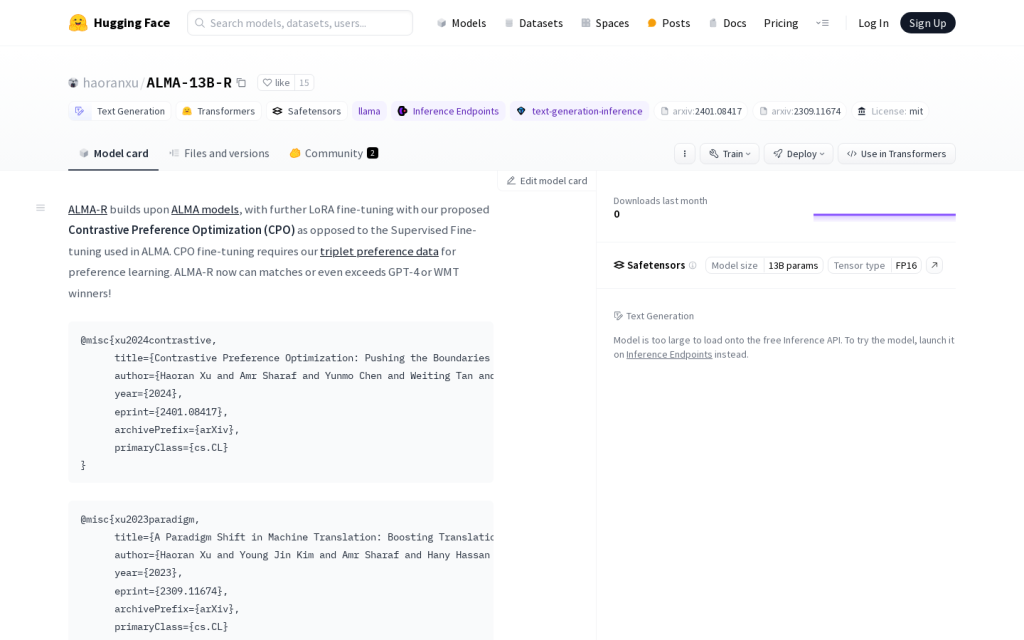

ALMA-R模型,透過Contrastive Preference Optimization (CPO)進行了進一步的LoRA微調,超越了GPT-4和WMT獲獎者。使用者可以在GitHub倉庫中下載ALMA(-R)模型和資料集。ALMA-R建立在ALMA模型的基礎上,採用了我們提出的Contrastive Preference Optimization (CPO)進行微調,而不是ALMA中使用的Supervised Fine-tuning。CPO微調需要我們的三元組偏好資料進行偏好學習。ALMA-R現在可以匹配甚至超越GPT-4或WMT獲獎者!