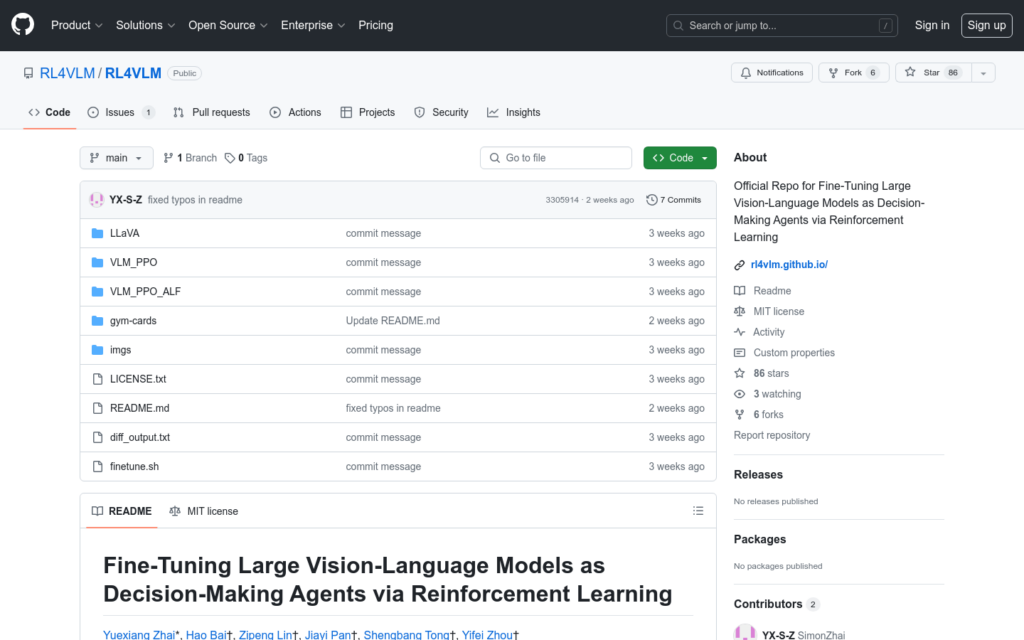

連結:https://github.com/RL4VLM/RL4VLM

RL4VLM是一個開源專案,旨在透過強化學習微調大型視覺-語言模型,使其成為能夠做出決策的智慧代理。該專案由Yuexiang Zhai, Hao Bai, Zipeng Lin, Jiayi Pan, Shengbang Tong, Alane Suhr, Saining Xie, Yann LeCun, Yi Ma, Sergey Levine等研究人員共同開發。它基於LLaVA模型,並採用了PPO演演算法進行強化學習微調。RL4VLM專案提供了詳細的程式碼庫結構、入門指南、許可證資訊以及如何引用該研究的說明。

需求人群:

- 目標受眾主要是機器學習和人工智慧領網網域的研究人員和開發者,他們需要利用視覺-語言模型進行決策制定和強化學習研究。

使用場景示例:

- 研究人員使用RL4VLM微調模型以改進自然語言處理任務中的決策制定能力。

- 開發者利用該專案提供的程式碼庫和環境來訓練自訂的視覺-語言模型。

- 教育機構將RL4VLM作為教學案例,向學生展示如何透過強化學習提升模型效能。

產品特色:

- 提供了修改版的LLaVA模型。

- 原創的GymCards環境。

- 為GymCards和ALFWorld環境提供的RL4VLM程式碼庫。

- 詳細的訓練流程,包括準備SFT檢查點和使用SFT檢查點執行RL。

- 提供了兩種不同的conda環境,以適應GymCards和ALFWorld的不同包需求。

- 提供了執行演演算法的詳細指南和範本腳本。

- 強調了使用特定檢查點作為起點的重要性,並提供了使用不同初始模型的靈活性。