連結:https://github.com/baaivision/EVE

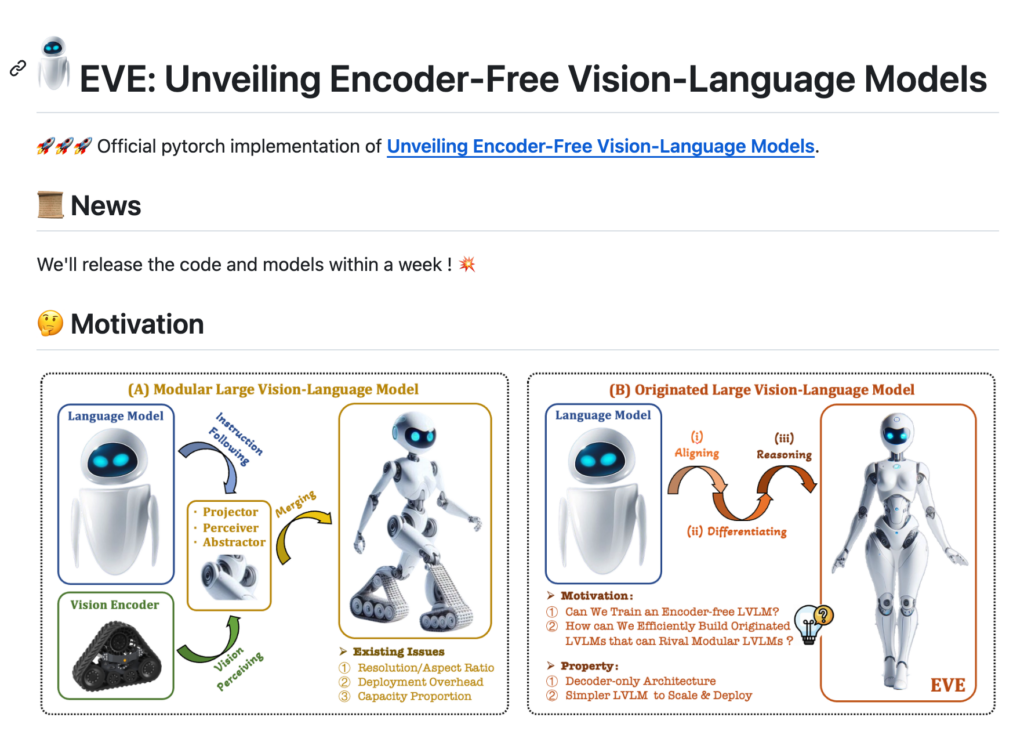

EVE是一個編碼器自由的視覺-語言模型,由大連理工大學、北京人工智慧研究院和北京大學的研究人員共同開發。它在不同影象寬高比下展現出卓越的能力,效能超越了Fuyu-8B,並且接近模組化編碼器基礎的LVLMs。EVE在資料效率、訓練效率方面表現突出,使用33M公開資料進行預訓練,並利用665K LLaVA SFT資料為EVE-7B模型訓練,以及額外的1.2M SFT資料為EVE-7B (HD)模型訓練。EVE的開發採用了高效、透明、實用的策略,為跨模態的純解碼器架構開闢了新途徑。

需求人群:

- EVE模型主要面向人工智慧領網網域的研究人員和開發者,特別是那些專注於視覺-語言任務和自然語言處理的專業人士。由於其高效的資料處理能力和訓練效率,EVE非常適合需要處理大規模視覺資料和語言模型的場景,同時對於推動人工智慧領網網域的發展具有重要意義。

使用場景示例:

- 研究人員使用EVE模型進行影象描述生成任務。

- 開發者利用EVE進行視覺問答系統的研發。

- 教育機構採用EVE模型教授視覺-語言模型的構建和應用。

產品特色:

- 任意影象寬高比的視覺-語言模型設計。

- 使用少量公開資料進行高效預訓練。

- 利用大量SFT資料進行進一步最佳化。

- 在訓練效率上,使用兩個8-A100 (40G)節點在約9天內完成訓練。

- 編碼器自由架構,簡化模型複雜性,提高透明度。

- 在多個視覺-語言任務上展現出優越的效能。

使用教學:

訪問EVE的GitHub頁面以獲取專案資訊和程式碼。

閱讀README檔案瞭解模型的安裝和配置要求。

根據指導下載並安裝必要的依賴項。

克隆或下載EVE模型的程式碼庫到本地環境。

遵循文檔中的步驟進行模型訓練或測試。

根據需要調整模型引數以適應不同的視覺-語言任務。

參與社群討論,獲取幫助或貢獻程式碼。