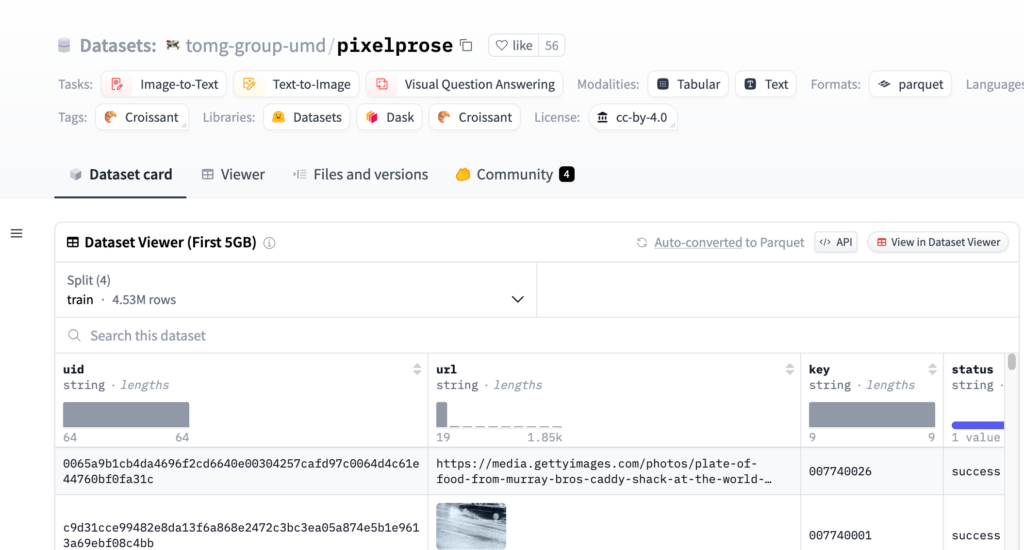

連結:https://huggingface.co/datasets/tomg-group-umd/pixelprose

PixelProse是一個由tomg-group-umd建立的大規模資料集,它利用先進的視覺-語言模型Gemini 1.0 Pro Vision生成了超過1600萬個詳細的影象描述。這個資料集對於開發和改進影象到文本的轉換技術具有重要意義,可以用於影象描述生成、視覺問答等任務。

需求人群:

目標受眾為機器學習和人工智慧領網網域的研究人員和開發者,特別是那些專注於影象辨識、影象描述生成和視覺問答系統的專家。該資料集的規模和多樣性使其成為訓練和測試這些系統的理想資源。

使用場景示例:

研究人員使用PixelProse資料集訓練一個影象描述生成模型,以自動為社交媒體上的圖片生成描述。

開發者利用該資料集開發了一個視覺問答應用,能夠回答使用者關於影象內容的問題。

教育機構使用PixelProse作為教學資源,幫助學生瞭解影象辨識和自然語言處理的基本原理。

產品特色:

提供超過16M的影象-文本配對。

支援多種任務,如影象到文本和文本到影象。

包含多種模態,包括表格和文本。

資料格式為parquet,易於機器學習模型處理。

包含詳細的影象描述,適用於訓練複雜的視覺-語言模型。

資料集分為CommonPool、CC12M和RedCaps三個部分。

提供影象的EXIF資訊和SHA256雜湊值,確保資料完整性。

使用教學:

第一步:訪問Hugging Face網站並搜尋PixelProse資料集。

第二步:選擇合適的下載方式,例如透過Git LFS、Huggingface API或直接連結下載parquet檔案。

第三步:使用parquet檔案中的URL下載相應的影象。

第四步:根據研究或開發需要,載入資料集並進行預處理。

第五步:使用資料集訓練或測試視覺-語言模型。

第六步:評估模型效能,並根據需要調整模型引數。

第七步:將訓練好的模型應用於實際問題或進一步的研究中。