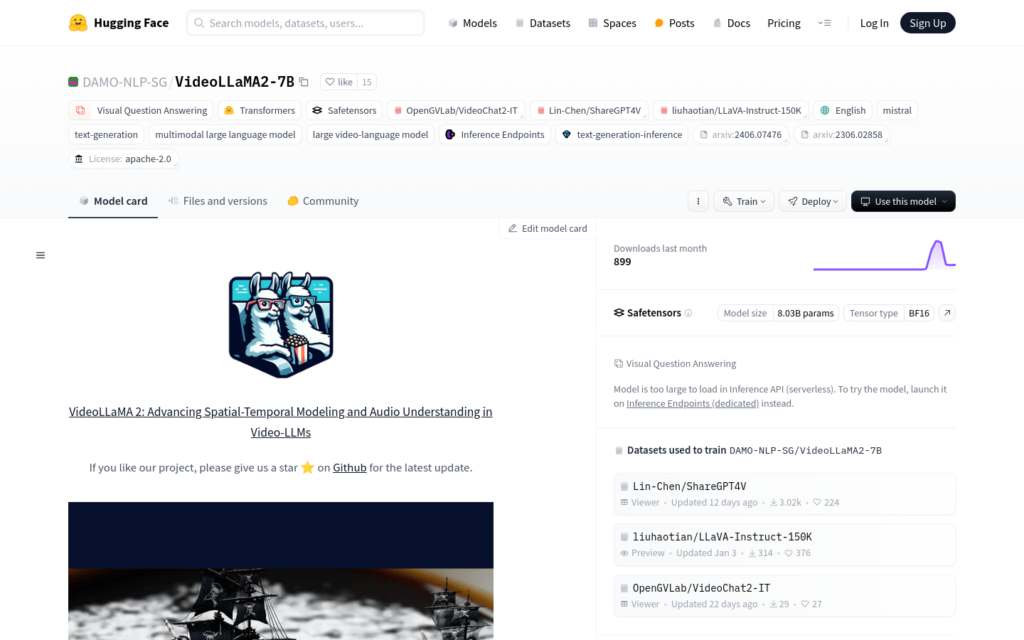

連結:https://huggingface.co/DAMO-NLP-SG/VideoLLaMA2-7B

VideoLLaMA2-7B是由DAMO-NLP-SG團隊開發的多模態大型語言模型,專注於影片內容的理解和生成。該模型在視覺問答和影片字幕生成方面具有顯著的效能,能夠處理複雜的影片內容,並生成準確、自然的語言描述。它在空間-時間建模和音訊理解方面進行了最佳化,為影片內容的智慧分析和處理提供了強大的支援。

需求人群:

- VideoLLaMA2-7B主要面向需要對影片內容進行深入分析和理解的研究人員和開發者,如影片內容推薦系統、智慧監控、自動駕駛等領網網域。它能夠幫助使用者從影片中提取有價值的資訊,提高決策效率。

使用場景示例:

- 在社交媒體上自動為使用者上傳的影片生成吸引人的字幕。

- 在教育領網網域,為教學影片提供互動式問答功能,增強學習體驗。

- 在安全監控中,透過影片問答快速定位關鍵事件,提高響應速度。

產品特色:

- 視覺問答:模型能夠理解影片內容並回答相關問題。

- 影片字幕生成:自動為影片生成描述性字幕。

- 空間-時間建模:最佳化模型對影片內容中物體運動和事件發展的理解。

- 音訊理解:提升模型對影片中音訊資訊的解析能力。

- 多模態互動:結合視覺和語言資訊,提供更豐富的互動體驗。

- 模型推理:支援在專用推理端點上進行高效模型推理。

使用教學:

步驟1:訪問VideoLLaMA2-7B的Hugging Face模型頁面。

步驟2:下載或克隆模型的程式碼庫,準備模型訓練和推理所需的環境。

步驟3:根據提供的示例程式碼,載入預訓練模型並進行配置。

步驟4:準備影片資料,進行必要的預處理,如影片幀提取和尺寸調整。

步驟5:使用模型進行影片問答或字幕生成,獲取結果並進行評估。

步驟6:根據需要調整模型引數,最佳化效能。

步驟7:將模型整合到實際應用中,實作自動化的影片內容分析。