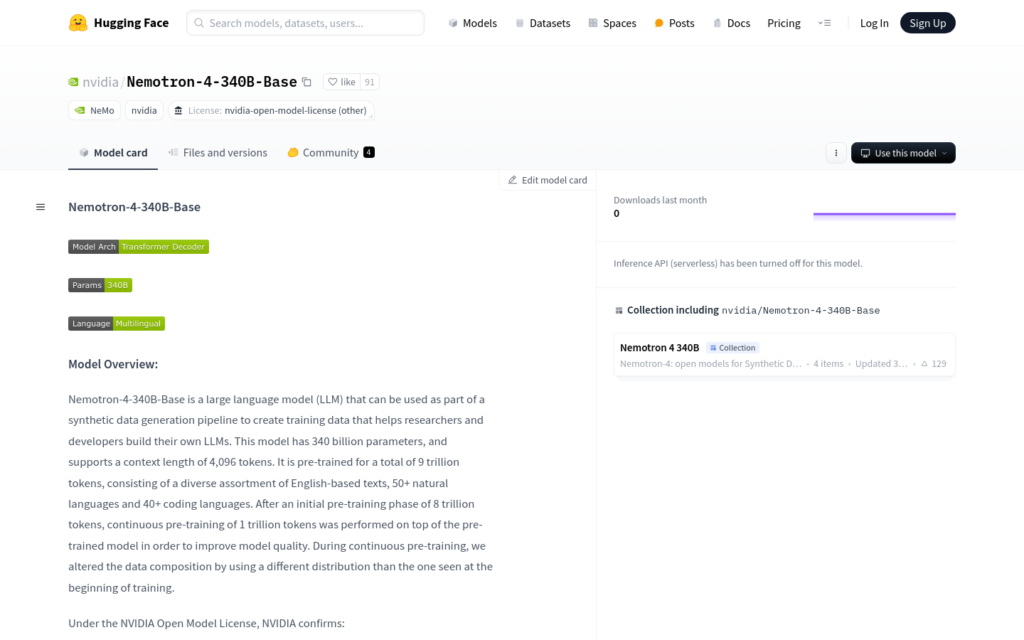

連結:https://huggingface.co/nvidia/Nemotron-4-340B-Base

Nemotron-4-340B-Base是由NVIDIA開發的大型語言模型,擁有3400億引數,支援4096個token的上下文長度,適用於生成合成資料,幫助研究人員和開發者構建自己的大型語言模型。模型經過9萬億token的預訓練,涵蓋50多種自然語言和40多種程式語言。NVIDIA開放模型許可允許商業使用和派生模型的建立與分發,不聲明對使用模型或派生模型生成的任何輸出擁有所有權。

需求人群:

- 目標受眾為研究人員和開發者,尤其是那些需要構建或訓練自己的大型語言模型的專業人士。該模型的多語言和程式語言支援,使其成為開發多語言應用程式和程式碼生成工具的理想選擇。

使用場景示例:

- 研究人員使用Nemotron-4-340B-Base生成訓練資料,以訓練特定領網網域的語言模型。

- 開發者利用模型的多語言能力,建立支援多種語言的聊天機器人。

- 教育機構使用該模型輔助學生學習程式設計,透過生成示例程式碼來解釋複雜概念。

產品特色:

- 支援50+自然語言和40+程式語言的文本生成。

- 相容NVIDIA NeMo框架,提供引數高效微調和模型對齊工具。

- 採用Grouped-Query Attention和Rotary Position Embeddings技術。

- 經過9萬億token的預訓練,包括多樣化的英文基礎文本。

- 支援BF16推理,可在多種硬體配置上部署。

- 提供5-shot和Zero-shot效能評估,展現多語言理解和程式碼生成能力。

使用教學:

1. 下載並安裝NVIDIA NeMo框架。

2. 準備所需的硬體環境,包括支援BF16推理的GPU。

3. 建立Python腳本以與部署的模型進行互動。

4. 建立Bash腳本來啟動推理伺服器。

5. 使用Slurm作業排程器在多個節點上分配模型並關聯推理伺服器。

6. 透過Python腳本傳送文本生成請求,並獲取模型生成的響應。