連結:

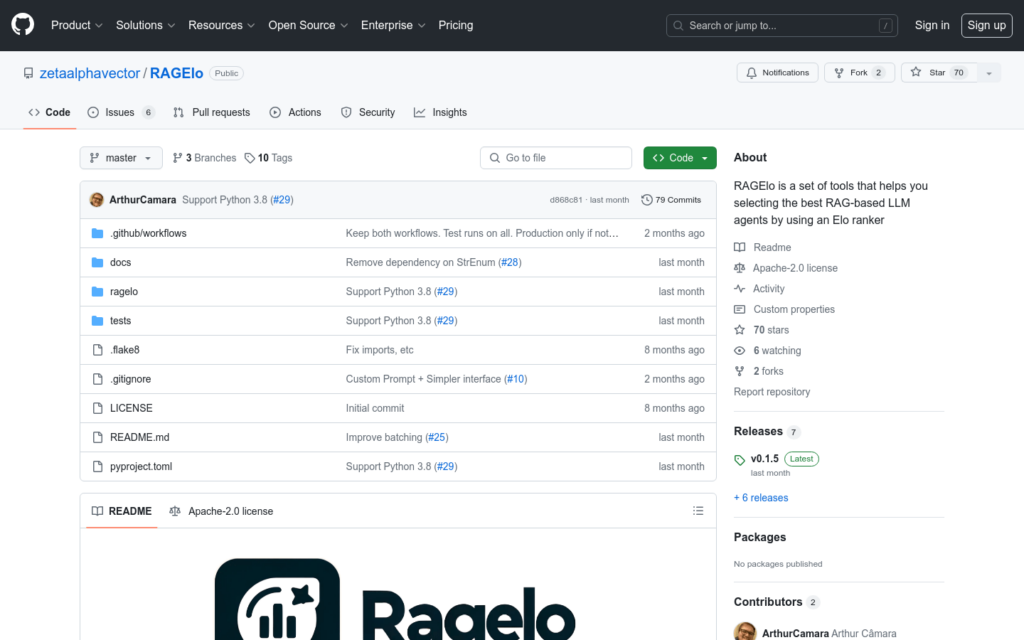

RAGElo是一個工具集,使用Elo評分系統幫助選擇最佳的基於檢索增強生成(RAG)的大型語言模型(LLM)代理。隨著生成性LLM在生產中的原型設計和整合變得更加容易,評估仍然是解決方案中最具有挑戰性的部分。RAGElo透過比較不同RAG管道和提示對多個問題的答案,計算不同設定的排名,提供了一個良好的概覽,瞭解哪些設定有效,哪些無效。

需求人群:

- RAGElo主要面向需要評估和選擇最優RAG-based LLM代理的開發者和研究人員。它特別適合於那些在生產環境中需要快速原型設計和整合生成性LLMs,同時面臨評估挑戰的使用者。

使用場景示例:

- 使用RAGElo評估不同RAG管道對問答任務的影響

- 利用RAGElo進行LLM代理的批量評估,以最佳化問答系統

- 將RAGElo整合到生產流程中,自動評估和選擇最佳的LLM代理

產品特色:

- 使用Elo評級系統評估RAG增強的LLM代理

- 支援Python庫和獨立CLI應用程式兩種使用方式

- 提供自訂提示和中繼資料注入功能,以增強評估過程

- 支援批量評估,允許同時評估多個響應

- CLI模式下,期望輸入檔案為CSV格式,簡化資料輸入

- 提供工具元件,如檢索評估器、答案註釋器和代理排名器

- 支援Python 3.8,適應最新的程式設計環境

使用教學:

1. 安裝RAGElo:使用pip命令安裝RAGElo庫或CLI應用程式。

2. 匯入RAGElo:在Python程式碼中匯入RAGElo模組。

3. 初始化評估器:根據需要選擇適當的評估器並進行初始化。

4. 進行評估:使用evaluate或batch_evaluate方法對單個或多個響應進行評估。

5. 自訂提示:根據評估需求,編寫自訂提示並注入中繼資料。

6. 分析結果:檢視評估結果,根據排名選擇最優的LLM代理。

7. 批量處理:如果需要評估大量資料,使用CLI模式並準備相應的CSV檔案。