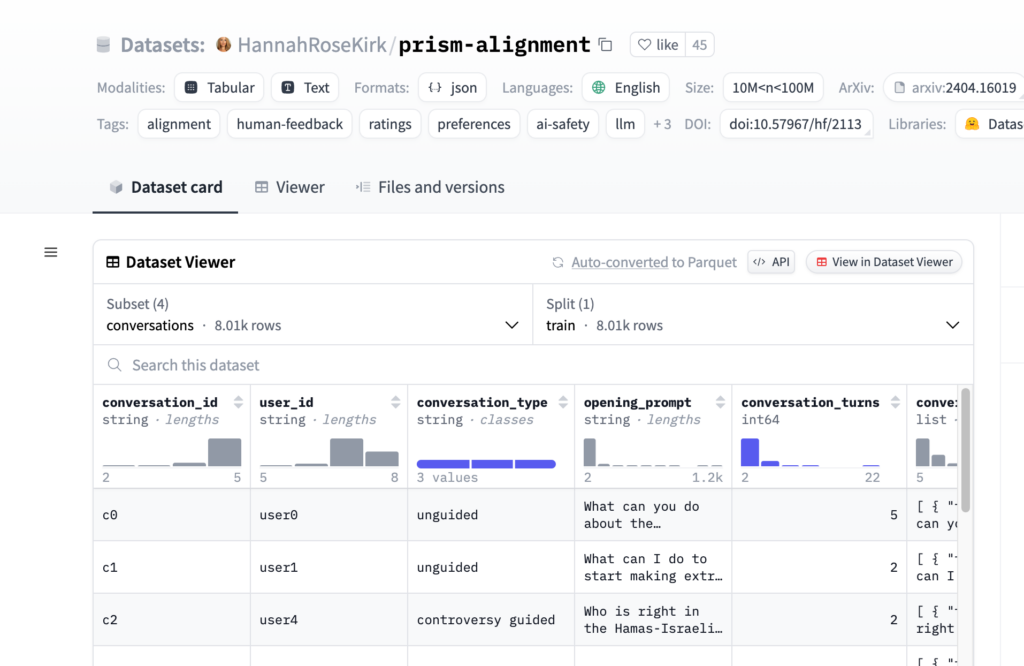

連結:https://huggingface.co/datasets/HannahRoseKirk/prism-alignment

prism-alignment 是一個由 HannahRoseKirk 建立的資料集,專注於研究大型語言模型(LLMs)的偏好和價值觀對齊問題。資料集透過調查問卷和與語言模型的多輪對話,收集了來自不同國家和文化背景的參與者對模型回答的評分和反饋。這些資料對於理解和改進人工智慧的價值觀對齊至關重要。

需求人群:

- prism-alignment 資料集的目標受眾主要是自然語言處理、人工智慧和社會科學領網網域的研究人員和學生。它適合那些對探索和改進 AI 價值觀對齊、進行跨文化研究或開發更符合人類價值觀的對話代理感興趣的使用者。

使用場景示例:

- 研究人員使用 prism-alignment 資料集來分析不同文化背景下人們對 AI 行為的偏好。

- 學生利用該資料集進行課程專案,探索 AI 倫理和價值觀問題。

- 開發者利用資料集中的反饋來訓練和最佳化對話系統,使其更加符合使用者的期望和價值觀。

產品特色:

- 包含多種模態,如表格和文本,以及多種格式,如 JSON。

- 涵蓋英語語言資料,大小在10M至100M之間。

- 資料集帶有詳細的標籤,如對齊、人類反饋、偏好、AI 安全等。

- 支援使用 pandas 和 mlcroissant 等庫進行資料處理。

- 遵循 Creative Commons 許可協定,鼓勵研究和教育使用。

- 資料集經過倫理審查,並由多方資助和支援。

使用教學:

第一步:訪問 Hugging Face 上的 prism-alignment 資料集頁面。

第二步:下載資料集,根據需要選擇合適的格式和子集。

第三步:使用 pandas 或 mlcroissant 等庫對資料進行載入和初步探索。

第四步:根據研究目的,篩選和分析資料集中的相關變數。

第五步:利用資料集中的反饋資訊來指導 AI 模型的訓練和最佳化。

第六步:在研究或專案中應用所得結論,改進 AI 的價值觀對齊。

第七步:遵循資料集的使用協定,正確引用資料集來源。