連結:https://huggingface.co/nvidia/Nemotron-4-340B-Instruct

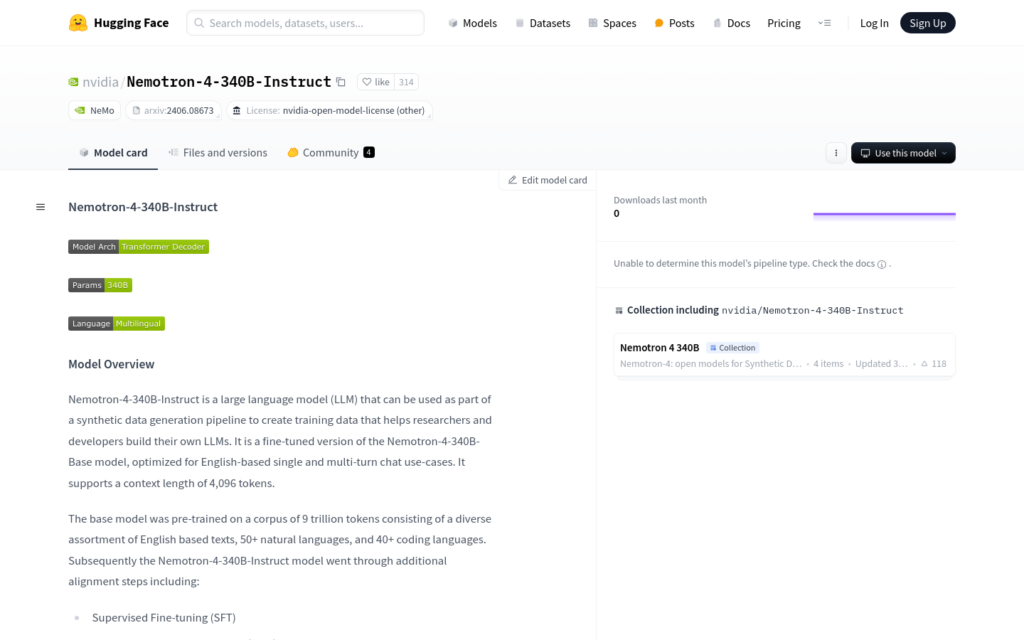

Nemotron-4-340B-Instruct是由NVIDIA開發的大型語言模型(LLM),專為英文單輪和多輪對話場景最佳化。該模型支援4096個token的上下文長度,經過監督式微調(SFT)、直接偏好最佳化(DPO)和獎勵感知偏好最佳化(RPO)等額外的對齊步驟。模型在約20K人工標註資料的基礎上,透過合成資料生成管道合成了超過98%的用於監督微調和偏好微調的資料。這使得模型在人類對話偏好、數學推理、編碼和指令遵循方面表現良好,並且能夠為多種用例生成高質量的合成資料。

需求人群:

- Nemotron-4-340B-Instruct模型面向需要構建或定製大型語言模型的開發者和企業。它特別適合於那些需要在英文對話、數學推理、程式設計指導等領網網域應用AI技術的使用者。

使用場景示例:

- 用於生成訓練資料,幫助開發者訓練定製化的對話系統。

- 在數學問題解答領網網域,提供準確的邏輯推理和解答生成。

- 輔助程式設計人員快速理解程式碼邏輯,提供程式設計指導和程式碼生成。

產品特色:

- 支援4096個token的上下文長度,適用於長文本處理。

- 經過SFT、DPO和RPO等對齊步驟,最佳化了對話和指令遵循能力。

- 能夠生成高質量的合成資料,助力開發者構建自己的LLM。

- 使用了Grouped-Query Attention (GQA)和Rotary Position Embeddings (RoPE)技術。

- 支援NeMo Framework的定製工具,包括引數高效微調和模型對齊。

- 在多種評估基準上表現優異,如MT-Bench、IFEval、MMLU等。

使用教學:

1. 使用NeMo Framework建立一個Python腳本與部署的模型進行互動。

2. 建立一個Bash腳本來啟動推理伺服器。

3. 使用Slurm作業排程系統將模型分佈在多個節點上,並與推理伺服器關聯。

4. 定義Python腳本中的文本生成函式,設定請求頭和資料結構。

5. 呼叫文本生成函式,傳入提示(prompt)和生成引數,獲取模型響應。

6. 根據需要調整生成引數,如溫度(temperature)、top_k、top_p等,以控制文本生成的風格和多樣性。

7. 透過調整系統提示(system prompt)來最佳化模型的輸出,以達到更好的對話效果。