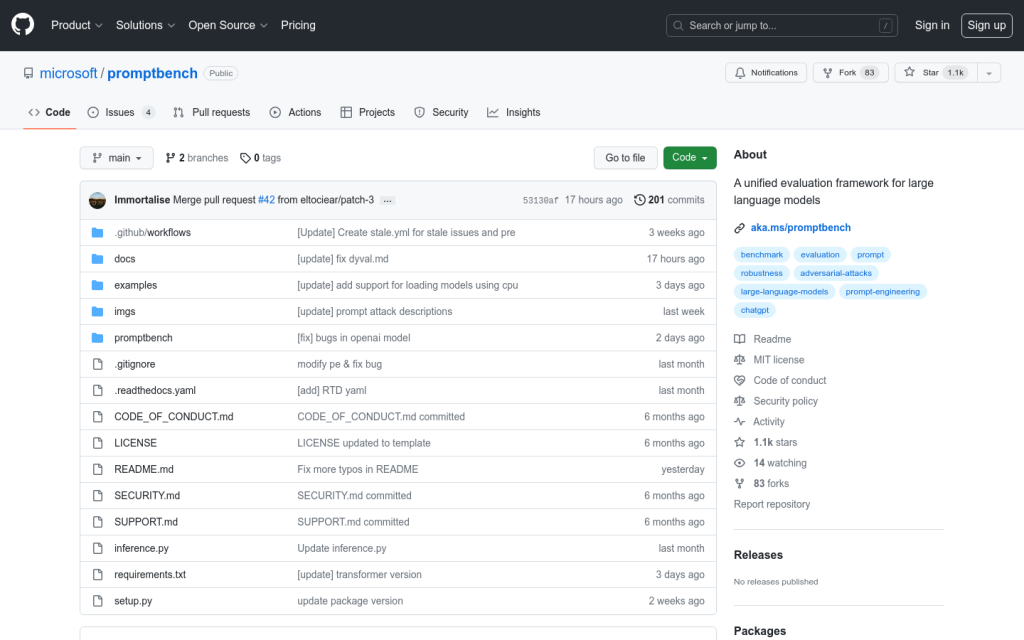

Link:promptbench

PromptBench是一個基於Pytorch的Python包,用於評估大型語言模型(LLM)。它為研究人員提供了使用者友好的API,以便對LLM進行評估。主要功能包括:快速模型效能評估、提示工程、對抗提示評估以及動態評估等。優勢是使用簡單,可以快速上手評估已有資料集和模型,也可以輕鬆定製自己的資料集和模型。定位為LLM評估的統一開源庫。

需求人群:

["評估語言模型效能","測試不同提示技術的效果","檢查對抗提示的穩健性","動態生成評估樣本"]

使用場景示例:

使用promptbench快速評估語言模型在GLUE基準上的效果

測試基於情感的提示技術對模型效能的影響

構建對抗性提示,評估模型的穩健性

使用DyVal動態生成樣本,進行模型評估

產品特色:

快速模型效能評估

提示工程

對抗提示評估

動態評估