連結:https://docs.vllm.ai/en/stable/

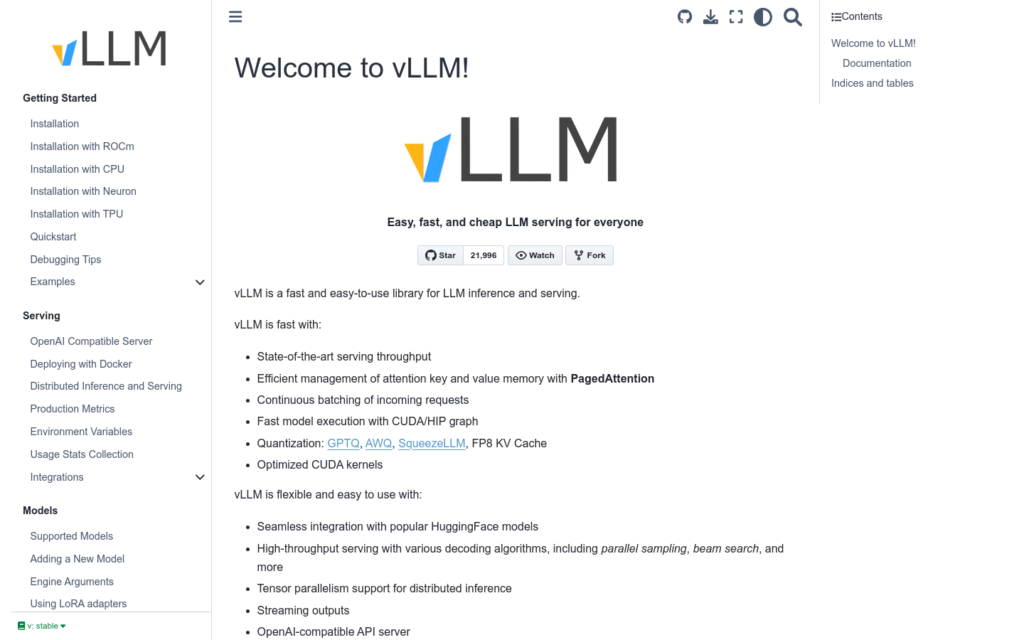

vLLM是一個為大型語言模型(LLM)推理和提供服務的快速、易用且高效的庫。它透過使用最新的服務吞吐量技術、高效的記憶體管理、連續批處理請求、CUDA/HIP圖快速模型執行、量化技術、最佳化的CUDA核心等,提供了高效能的推理服務。vLLM支援與流行的HuggingFace模型無縫整合,支援多種解碼演演算法,包括並行取樣、束搜尋等,支援張量並行性,適用於分散式推理,支援流式輸出,併相容OpenAI API伺服器。此外,vLLM還支援NVIDIA和AMD GPU,以及實驗性的字首快取和多lora支援。

需求人群:

“vLLM的目標受眾主要是需要進行大型語言模型推理和提供服務的開發者和企業。它適合於那些需要快速、高效地部署和執行大型語言模型的應用場景,如自然語言處理、機器翻譯、文本生成等。”

使用場景示例:

使用vLLM部署一個聊天機器人,提供自然語言互動服務

整合vLLM到一個機器翻譯服務中,提高翻譯速度和效率

使用vLLM進行文本生成,如自動撰寫資訊報道或社交媒體內容

產品特色:

支援與HuggingFace模型的無縫整合

提供高吞吐量的服務,支援多種解碼演演算法

支援張量並行性,適用於分散式推理

支援流式輸出,提高服務效率

相容OpenAI API伺服器,方便整合現有系統

支援NVIDIA和AMD GPU,提高硬體相容性

使用教學:

1. 安裝vLLM庫及其依賴項

2. 根據文檔配置環境變數和使用統計收集

3. 選擇並整合所需的模型

4. 配置解碼演演算法和效能調優引數

5. 編寫程式碼實作推理服務,包括請求處理和響應生成

6. 使用Docker部署vLLM服務,確保服務的穩定性和可擴充性

7. 監控生產指標,最佳化服務效能