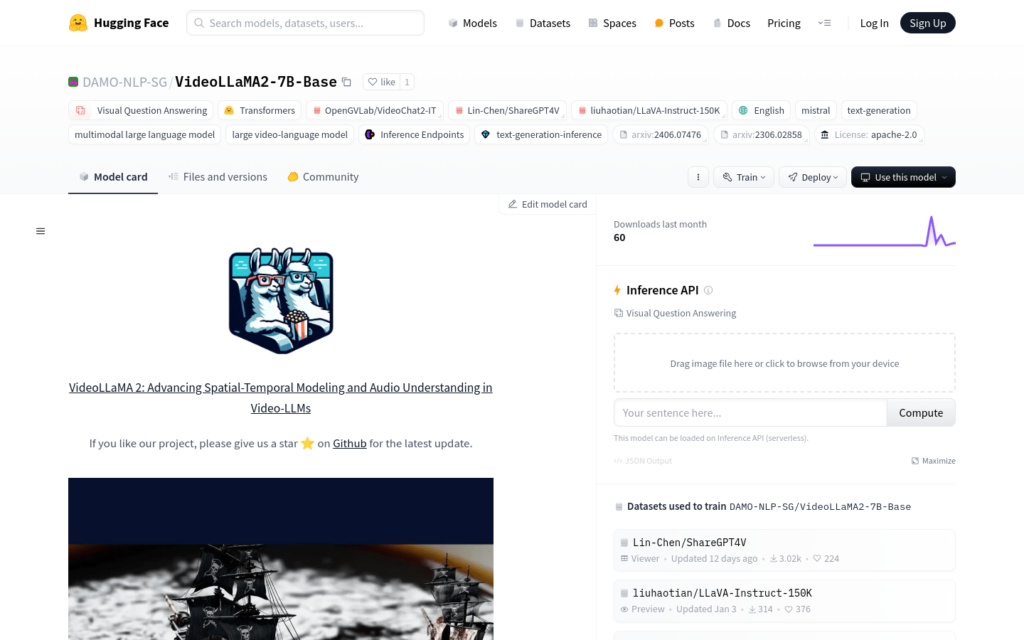

連結:https://huggingface.co/DAMO-NLP-SG/VideoLLaMA2-7B-Base

VideoLLaMA2-7B-Base 是由 DAMO-NLP-SG 開發的大型影片語言模型,專注於影片內容的理解與生成。該模型在視覺問答和影片字幕生成方面展現出卓越的效能,透過先進的空間時間建模和音訊理解能力,為使用者提供了一種新的影片內容分析工具。它基於 Transformer 架構,能夠處理多模態資料,結合文本和視覺資訊,生成準確且富有洞察力的輸出。

需求人群:

- 目標受眾包括影片內容分析研究人員、影片製作者、多模態學習開發者等。該產品適合需要對影片內容進行深入分析和理解的專業人士,以及希望自動化影片字幕生成的創作者。

使用場景示例:

- 研究人員使用模型分析社交媒體上的影片內容,以研究公眾情緒。

- 影片製作者自動為教學影片生成字幕,提高內容的可訪問性。

- 開發者將模型整合到自己的應用中,提供影片內容的自動摘要服務。

產品特色:

- 視覺問答:模型能夠理解影片內容並回答相關問題。

- 影片字幕生成:自動為影片生成描述性字幕。

- 多模態處理:結合文本和視覺資訊進行綜合分析。

- 空間時間建模:最佳化影片內容的空間和時間特徵理解。

- 音訊理解:增強模型對影片中音訊資訊的解析能力。

- 模型推理:提供推理接口,快速生成模型輸出。

- 程式碼支援:提供訓練、評估和推理的程式碼,方便二次開發。

使用教學:

1. 訪問 Hugging Face 模型庫頁面,選擇 VideoLLaMA2-7B-Base 模型。

2. 閱讀模型文檔,瞭解模型的輸入輸出格式和使用限制。

3. 下載或克隆模型的程式碼庫,準備進行本地部署或二次開發。

4. 根據程式碼庫中的說明,安裝必要的依賴項和環境。

5. 執行模型的推理程式碼,輸入影片檔案和相關問題,獲取模型的輸出。

6. 分析模型輸出,根據需要調整模型引數或進行進一步的開發。