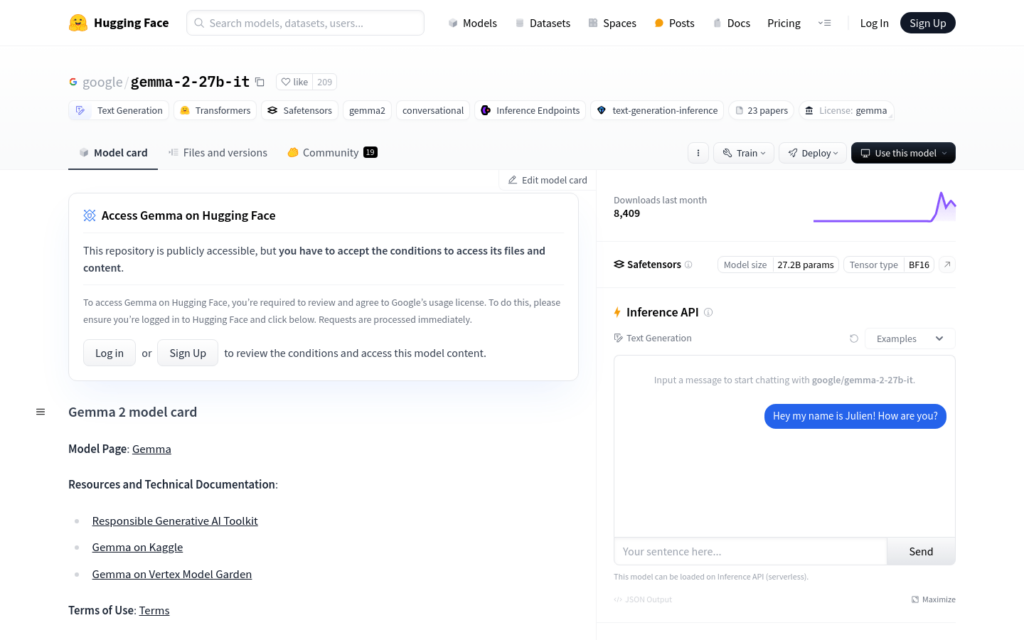

連結:https://huggingface.co/google/gemma-2-27b-it

Gemma是由Google開發的一系列輕量級、先進的開放模型,基於與Gemini模型相同的研究和技術構建。它們是文本到文本的解碼器僅大型語言模型,適用於多種文本生成任務,如問答、摘要和推理。Gemma模型的相對較小的尺寸使其能夠在資源有限的環境中部署,如筆記型電腦、桌面或您自己的雲基礎設施,使每個人都能接觸到最先進的AI模型,並促進創新。

需求人群:

- Gemma模型的目標受眾是希望在資源受限的環境中利用AI技術進行文本生成的開發者和研究人員。無論是在個人專案、學術研究還是商業應用中,Gemma都能提供高效且易於部署的解決方案。

使用場景示例:

- 使用Gemma模型生成關於機器學習的詩歌

- 作為聊天機器人的後端,提供對話式的文本生成服務

- 在教育領網網域,輔助學生進行程式語言的學習或提供程式設計問題的解答

產品特色:

- 支援多種文本生成任務,包括問答、摘要和推理

- 適用於資源有限的環境,如筆記型電腦和桌面

- 開放權重,適用於預訓練變體和指令調整變體

- 支援在GPU上執行,且支援不同精度配置,包括bfloat16、float16和float32

- 提供了量化版本,透過bitsandbytes庫支援8位和4位精度

- 支援使用Flash Attention 2最佳化模型的執行效率

使用教學:

首先,確保全裝了必要的庫,如transformers和accelerate。

使用AutoTokenizer和AutoModelForCausalLM從transformers庫匯入模型和分詞器。

根據需要設定模型的精度和設備對映。

定義輸入文本並使用分詞器將其轉換為模型可接受的輸入格式。

呼叫模型的generate方法生成文本輸出。

使用tokenizer的decode方法將輸出的token序列轉換回可讀文本。