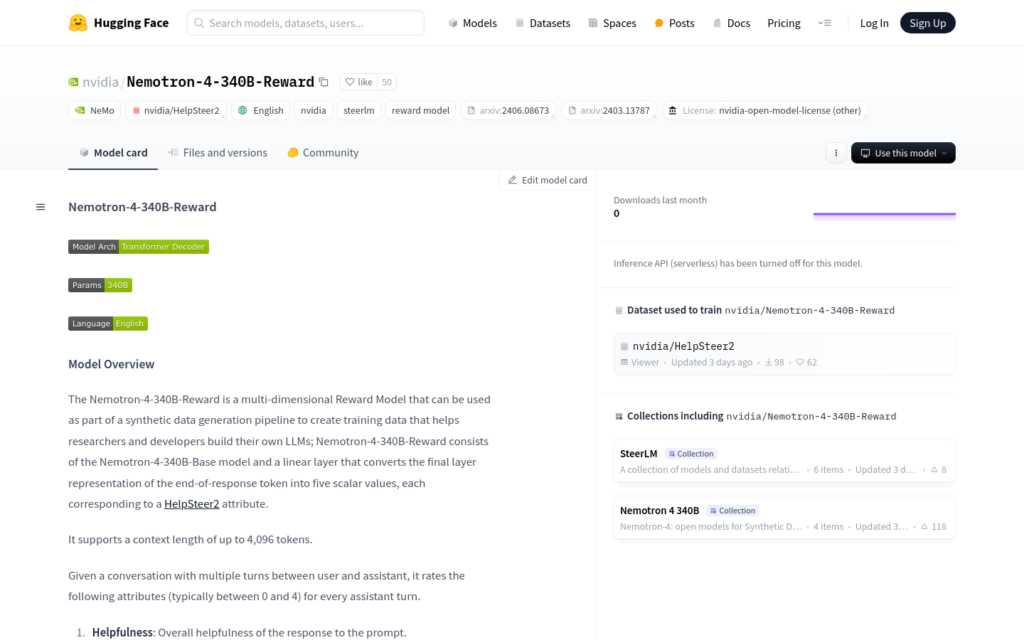

連結:https://huggingface.co/nvidia/Nemotron-4-340B-Reward

Nemotron-4-340B-Reward是由NVIDIA開發的多維獎勵模型,用於合成資料生成管道,幫助研究人員和開發者構建自己的大型語言模型(LLMs)。該模型由Nemotron-4-340B-Base模型和一個線性層組成,能夠將響應末尾的標記轉換為五個標量值,對應於HelpSteer2屬性。它支援最多4096個標記的上下文長度,並能夠對每個助手輪次的五個屬性進行評分。

需求人群:

- 目標受眾為AI研究人員和開發者,特別是那些致力於構建和最佳化大型語言模型的專業人士。此模型能夠幫助他們透過合成資料生成和強化學習技術,提高模型的效能和對齊度。

使用場景示例:

- 研究人員使用Nemotron-4-340B-Reward模型來評估和改進他們自己構建的語言模型。

- 開發者利用該模型在對話系統開發中生成訓練資料,以提高系統對使用者查詢的響應質量。

- 教育機構採用此模型作為教學工具,幫助學生理解大型語言模型的工作原理和最佳化方法。

產品特色:

- 支援最多4096個標記的上下文長度。

- 能夠對助手的回應進行五個屬性的評分:有幫助性、正確性、連貫性、複雜性和冗餘度。

- 可以作為傳統的獎勵模型使用,輸出單一標量值。

- 在NVIDIA開放模型許可下,模型商業可用,允許建立和分發衍生模型。

- 適用於英語合成資料生成和基於AI反饋的英語強化學習。

- 可以用於對預訓練模型進行對齊,以符合人類偏好,或作為獎勵模型作為評判使用。

使用教學:

1. 訪問Nemotron-4-340B-Reward模型的網頁連結。

2. 閱讀模型概述和使用說明,瞭解模型的功能和限制。

3. 根據需要設定模型引數,如上下文長度和評分屬性權重。

4. 使用模型進行資料生成或模型對齊,根據輸出結果調整模型配置。

5. 將模型整合到現有的AI專案中,以提高系統的智慧性和響應質量。

6. 定期更新模型,以利用最新的研究成果和技術進步。