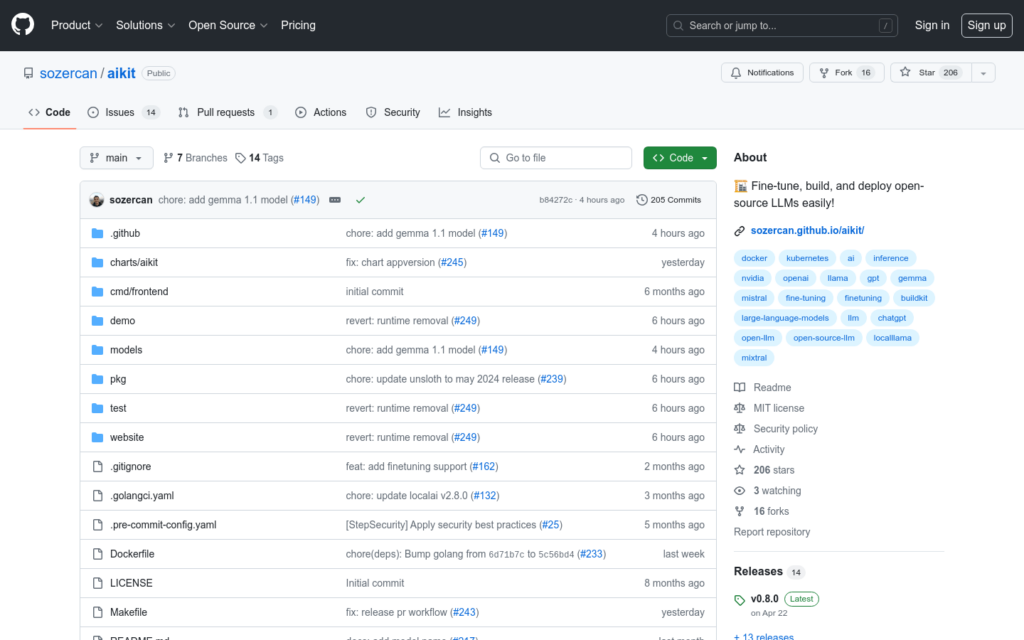

連結:https://github.com/sozercan/aikit

AIKit 是一個開源工具,旨在簡化大型語言模型(LLMs)的託管、部署、構建和微調過程。它提供了與OpenAI API相容的REST API,支援多種推理能力和格式,使使用者可以使用任何相容的使用者端傳送請求。此外,AIKit 還提供了一個可擴充的微調接口,支援Unsloth,為使用者提供快速、記憶體高效且易於使用的微調體驗。

需求人群:

- AIKit 適合開發者、資料科學家和機器學習工程師,他們需要一個簡單、高效且成本效益高的方式來部署和微調大型語言模型。無論是在本地機器上還是在雲環境中,AIKit都能提供強大的支援。

使用場景示例:

- 使用AIKit快速啟動本地機器上的LLMs,無需GPU。

- 透過AIKit部署Kubernetes上的LLMs,實作自動化部署和管理。

- 利用AIKit的微調功能,對特定領網網域的資料進行模型訓練。

產品特色:

- 使用LocalAI進行廣泛的推理能力支援,相容OpenAI API。

- 提供Unsloth支援的可擴充微調接口。

- 無需GPU、網際網路訪問或額外工具,只需Docker即可執行。

- 最小化的映象大小,減少漏洞和攻擊面。

- 支援聲明式配置,簡化推理和微調過程。

- 支援多模態模型和影象生成。

- 支援多種模型格式,如GGUF、GPTQ、EXL2、GGML和Mamba。

- 支援Kubernetes部署,以及NVIDIA GPU加速推理。

- 支援非專有和自託管的容器登入檔來儲存模型映象。

使用教學:

- 1. 安裝Docker以執行AIKit。

- 2. 從GitHub克隆AIKit倉庫或直接使用預構建的Docker映象。

- 3. 根據需要配置AIKit的推理和微調引數。

- 4. 使用Docker命令啟動AIKit服務。

- 5. 透過OpenAI相容的API使用者端傳送請求。

- 6. 根據反饋調整模型配置,最佳化效能。

- 7. 如有需要,可以建立自訂模型映象並部署到容器登入檔中。