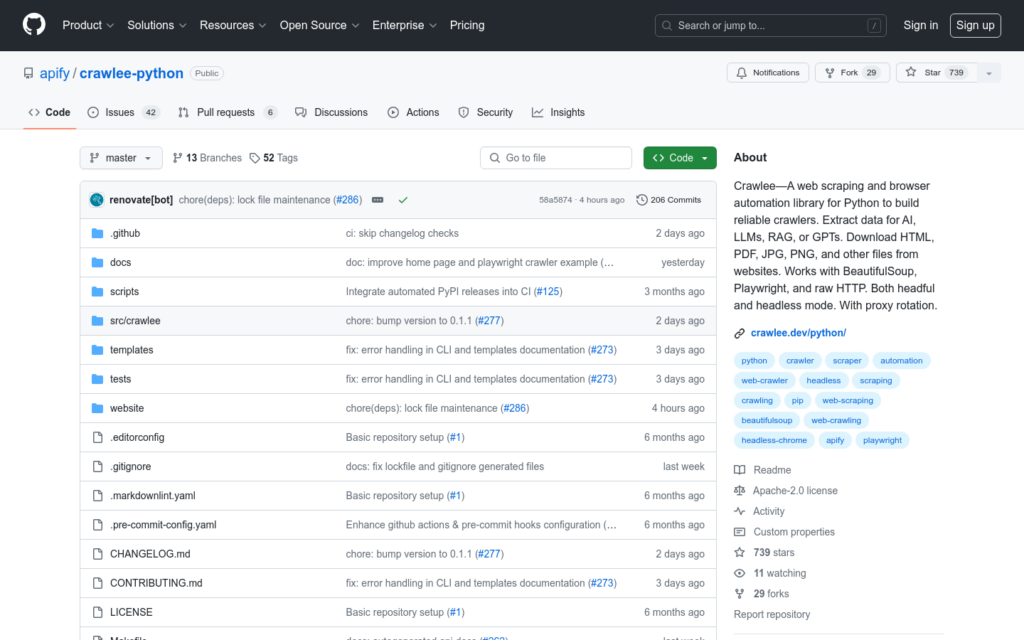

連結:https://github.com/apify/crawlee-python

Crawlee 是一個用於構建可靠爬蟲的 Python 網路爬蟲和瀏覽器自動化庫,提取資料用於AI、LLMs、RAG或GPTs。它提供了統一的接口來處理 HTTP 和無頭瀏覽器爬取任務,支援自動並行爬取,基於系統資源進行調整。Crawlee 用 Python 編寫,包含型別提示,增強了開發體驗並減少了錯誤。它具備自動重試、整合代理輪換和會話管理、可配置的請求路由、持久化 URL 佇列、可插拔的儲存選項等功能。相較於 Scrapy,Crawlee 提供了對無頭瀏覽器爬取的原生支援,擁有簡潔優雅的接口,並且完全基於標準的非同步 IO。

需求人群:

- Crawlee 適合需要構建資料爬取和網頁自動化工具的開發者。無論是需要從靜態 HTML 頁面還是依賴使用者端 JavaScript 生成內容的動態網站中提取資料,Crawlee 都能夠提供強大的支援。它的易用性和靈活性使其成為資料科學家、機器學習工程師和 web 開發者的理想選擇。

使用場景示例:

- 使用 BeautifulSoupCrawler 高效提取 HTML 內容資料。

- 利用 PlaywrightCrawler 處理 JavaScript 重型網站的資料抓取。

- 透過 Crawlee CLI 快速啟動和配置新的爬蟲專案。

產品特色:

- 統一的 HTTP 和無頭瀏覽器爬取接口

- 基於系統資源的自動並行爬取

- Python 型別提示,增強開發體驗

- 自動錯誤重試和防屏蔽功能

- 整合代理輪換和會話管理

- 可配置的請求路由和持久化 URL 佇列

- 支援多種資料和檔案儲存方式

- 健壯的錯誤處理機制

使用教學:

安裝 Crawlee: pip install crawlee

根據需要安裝額外的依賴,例如 beautifulsoup 或 playwright

使用 Crawlee CLI 建立新的爬蟲專案: pipx run crawlee create my-crawler

選擇一個範本並根據專案需求進行配置

編寫爬蟲邏輯,包括資料提取和連結抓取

執行爬蟲並觀察結果