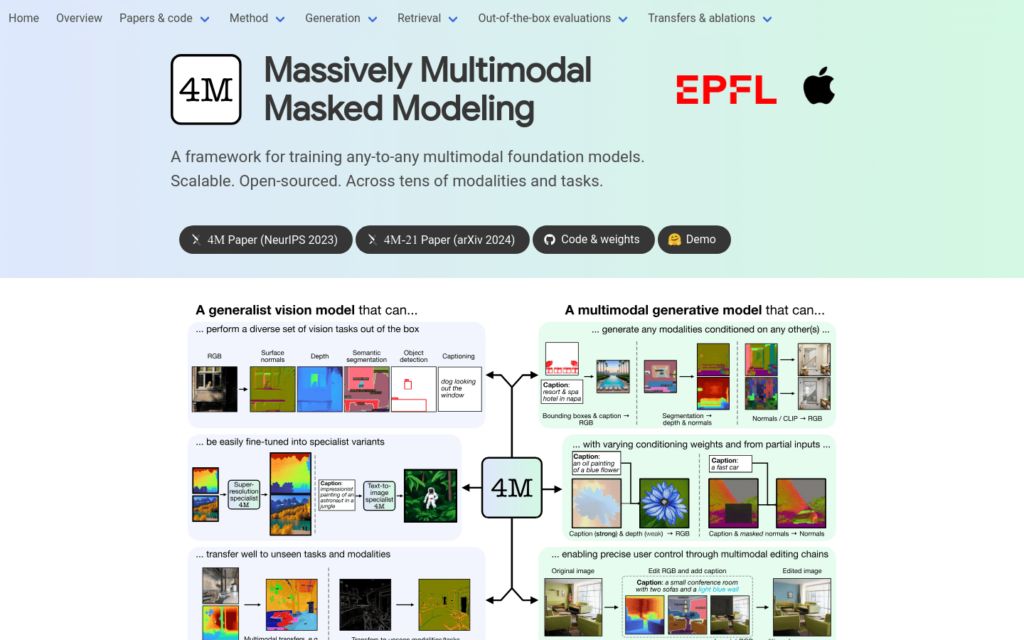

4M是一個用於訓練多模態和多工模型的框架,能夠處理多種視覺任務,並且能夠進行多模態條件生成。該模型透過實驗分析展示了其在視覺任務上的通用性和可擴充性,為多模態學習在視覺和其他領網網域的進一步探索奠定了基礎。

需求人群:

- 4M模型的目標受眾是電腦視覺和機器學習領網網域的研究人員和開發者,特別是那些對多模態資料處理和生成模型感興趣的專業人士。該技術可以應用於影象和影片分析、內容創作、資料增強和多模態互動等場景。

使用場景示例:

- 使用4M模型從RGB影象生成深度圖和表面法線。

- 利用4M進行影象編輯,如根據部分輸入重構完整的RGB影象。

- 在多模態檢索中,使用4M模型根據文本描述檢索相應的影象。

產品特色:

- 多模態和多工訓練方案,能夠預測或生成任何模態。

- 透過將模態轉換為離散標記序列,可以在統一的Transformer編碼器-解碼器上訓練。

- 支援從部分輸入進行預測,實作多模態鏈式生成。

- 能夠根據任意子集的其他模態生成任何模態,實作自我一致的預測。

- 支援細粒度的多模態生成和編輯任務,如語義分割或深度圖。

- 可進行可控的多模態生成,透過不同條件的權重控制生成輸出。

- 支援多模態檢索,透過預測DINOv2和ImageBind模型的全網域嵌入來實作。

使用教學:

- 訪問4M的GitHub倉庫以獲取程式碼和預訓練模型。

- 根據文檔說明安裝所需的依賴項和環境。

- 下載並載入預訓練的4M模型。

- 準備輸入資料,可以是文本、影象或其他模態。

- 根據需要選擇生成任務或檢索任務。

- 執行模型並觀察結果,根據需要調整引數。

- 對生成的輸出進行後處理,如將生成的標記轉換回影象或其他模態。