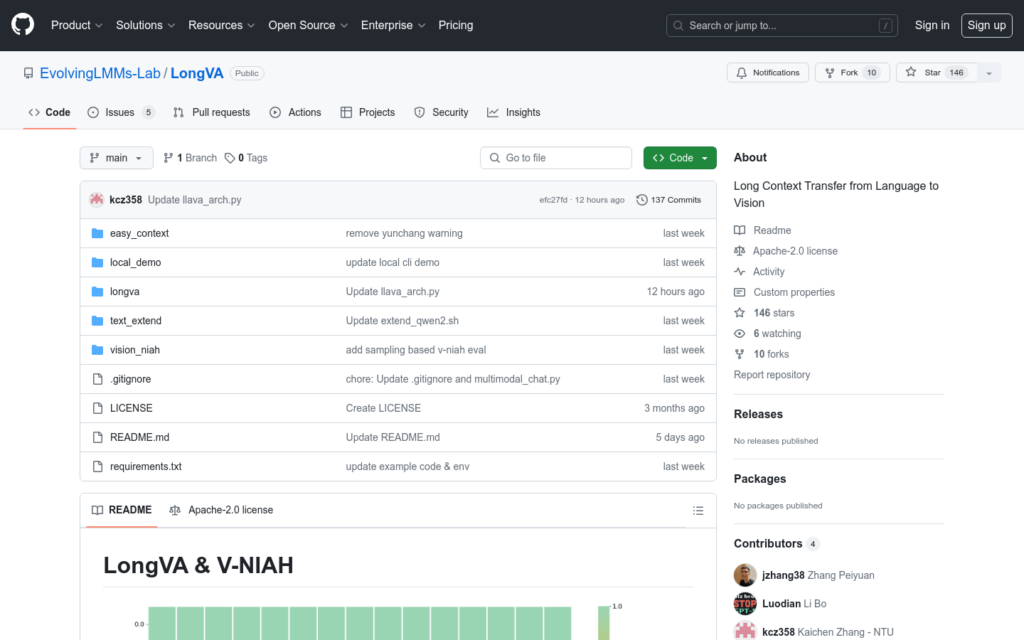

連結:https://github.com/evolvinglmms-lab/longva

LongVA是一個能夠處理超過2000幀或超過200K視覺標記的長上下文轉換模型。它在Video-MME中的表現在7B模型中處於領先地位。該模型基於CUDA 11.8和A100-SXM-80G進行了測試,並且可以透過Hugging Face平臺進行快速啟動和使用。

需求人群:

- 目標受眾主要是研究人員和開發者,特別是那些在影象和影片處理、多模態學習、自然語言處理領網網域尋求創新解決方案的專業人士。LongVA模型適合他們因為它提供了一種強大的工具來探索和實作複雜的視覺和語言任務。

使用場景示例:

- 研究人員使用LongVA模型進行影片內容的自動描述生成。

- 開發者利用LongVA進行影象和影片的多模態聊天應用開發。

- 教育機構採用LongVA模型進行視覺和語言教學的輔助工具開發。

產品特色:

- 處理長影片和大量視覺標記,實作語言到視覺的零樣本轉換。

- 在影片多模態評估(Video-MME)中取得優異表現。

- 支援CLI(命令列介面)和基於gradio UI的多模態聊天演示。

- 提供Hugging Face平臺的快速啟動程式碼示例。

- 支援自訂生成引數,如取樣、溫度、top_p等。

- 提供V-NIAH和LMMs-Eval的評估腳本,用於模型效能測試。

- 支援長文本訓練,可在多GPU環境下進行高效訓練。

使用教學:

1. 安裝必要的依賴項,包括CUDA 11.8和PyTorch 2.1.2。

2. 透過pip安裝LongVA模型及其依賴。

3. 下載並載入預訓練的LongVA模型。

4. 準備輸入資料,可以是影象或影片檔案。

5. 使用CLI或gradio UI進行模型的互動和測試。

6. 根據需要調整生成引數,以獲得最佳結果。

7. 執行評估腳本,測試模型在不同任務上的效能。